Chef: обзор возможностей и отличий от Kubernetes

В эволюции инструментов управления инфраструктурой Chef занял особое место как один из пионеров в области автоматизации конфигурации серверов. Подобно тому, как опытный шеф-повар следует проверенным рецептам для создания идеальных блюд, Chef использует «рецепты» (recipes) и «поваренные книги» (cookbooks) для автоматизации настройки серверов и приложений.

Архитектура Chef построена на трех ключевых компонентах:

- Chef Server — центральный узел системы, хранящий конфигурации и метаданные

- Chef Workstation — рабочие станции, с которых администраторы создают и тестируют конфигурации

- Chef Nodes — управляемые серверы, на которых выполняются конфигурации

В отличие от Kubernetes, который фокусируется на оркестрации контейнеров, Chef специализируется на управлении конфигурацией на уровне операционной системы. Он позволяет автоматизировать:

- Установку и настройку программного обеспечения

- Управление системными сервисами

- Конфигурацию сетевых параметров

- Развертывание приложений в традиционной серверной среде

Типичный рабочий процесс в Chef выглядит следующим образом:

# Пример простого рецепта Chef package 'nginx' do action :install end service 'nginx' do action [:enable, :start] end template '/etc/nginx/nginx.conf' do source 'nginx.conf.erb' notifies :restart, 'service[nginx]' end

Хотя Chef и Kubernetes решают разные задачи, они часто дополняют друг друга в современных инфраструктурных решениях. Chef может использоваться для первоначальной настройки серверов, на которых впоследствии будет развернут Kubernetes-кластер, обеспечивая тем самым комплексный подход к автоматизации инфраструктуры.

Понимание принципов работы Chef помогает лучше оценить те революционные изменения, которые Kubernetes привнес в мир контейнерной оркестрации. Давайте рассмотрим подробнее, как Kubernetes развивает и дополняет подходы к автоматизации, заложенные его предшественниками.

В современном мире цифровой трансформации мы наблюдаем стремительный рост сложности инфраструктурных решений. Подобно тому, как Chef произвел революцию в управлении конфигурациями серверов, Kubernetes (или K8s, как его часто называют в профессиональных кругах) совершил настоящий переворот в области оркестрации контейнеров и управления микросервисными архитектурами.

Представьте себе огромный современный ресторан, где десятки поваров готовят сотни блюд одновременно. Без четкой системы управления, координации и распределения ресурсов такая кухня быстро превратилась бы в хаос. Kubernetes играет роль виртуального шеф-повара в мире контейнеризированных приложений, обеспечивая автоматизацию развертывания, масштабирования и управления контейнеризированными приложениями.

Изначально разработанный инженерами Google и позже переданный в открытый доступ, он стал де-факто стандартом в индустрии. Согласно ежегодному исследованию Cloud Native Computing Foundation (CNCF) за 2020 год, 96% организаций-респондентов сообщили об использовании Kubernetes, что наглядно демонстрирует его доминирующее положение в сфере оркестрации контейнеров

Почему же это решение получило такое широкое распространение? Ответ кроется в его универсальности и масштабируемости. Он предоставляет единый интерфейс управления для приложений любой сложности – от небольших стартапов до крупных enterprise-решений. При этом система достаточно гибкая, чтобы адаптироваться под специфические требования каждого проекта.

Круговая диаграмма, которая иллюстрирует распределение задач между Kubernetes, Chef и другими инструментами

В эпоху, когда время вывода продукта на рынок становится критическим фактором успеха, способность быстро развертывать и масштабировать приложения превращается в конкурентное преимущество. Именно здесь Kubernetes демонстрирует свою истинную ценность, автоматизируя рутинные операции и позволяя командам разработчиков сосредоточиться на создании бизнес-функционала.

Давайте рассмотрим подробнее, как работает эта технология и почему она стала неотъемлемой частью современного DevOps-ландшафта.

- Основные понятия и архитектура

- Установка и настройка среды

- Использование Minikube для локальной разработки

- Развертывание приложений

- Финтех-сектор

- E-commerce платформа

- Медиа-компания

- Преимущества:

- Недостатки:

- Docker Swarm

- Apache Mesos

- OpenShift (основан на Kubernetes)

Основные понятия и архитектура

При знакомстве с Kubernetes мы сталкиваемся с целым набором специфических терминов и концепций, которые, подобно кубикам конструктора, формируют целостную систему. Давайте разберем ключевые компоненты этой архитектуры, без понимания которых невозможно эффективное использование платформы.

Центральным элементом архитектуры Kubernetes является кластер – набор узлов (nodes), работающих как единая система. В этой структуре выделяются следующие основные компоненты:

- Control Plane (плоскость управления) – «мозговой центр» кластера, отвечающий за принятие глобальных решений

- Nodes (узлы) – рабочие машины, на которых выполняются контейнеризированные приложения

- Pods (поды) – наименьшие развертываемые единицы в Kubernetes, содержащие один или несколько контейнеров

- Services (сервисы) – абстракции, определяющие логический набор подов и политику доступа к ним

- Volumes (тома) – компоненты для хранения данных, которые могут использоваться подами

Особого внимания заслуживает механизм взаимодействия между этими компонентами. Подобно тому, как в системе Chef мы имеем центральный сервер и подключенные к нему ноды, в Kubernetes control plane координирует работу всех узлов, обеспечивая их эффективное взаимодействие и распределение нагрузки.

Такая архитектура обеспечивает высокую отказоустойчивость и масштабируемость системы, позволяя гибко управлять ресурсами и оперативно реагировать на изменения нагрузки. Но возникает вопрос: как же правильно развернуть и настроить такую сложную систему?

Установка и настройка среды

В мире современной разработки процесс установки и настройки инструментов часто становится первым серьезным испытанием для команды. В случае с Kubernetes мы имеем дело с комплексной системой, установка которой требует внимательного подхода и понимания особенностей различных операционных систем.

Прежде всего, для успешного развертывания Kubernetes необходимо обеспечить наличие следующих компонентов:

- Docker или другой совместимый runtime для контейнеров

- kubelet – основной агент, работающий на каждом узле

- kubeadm – инструмент для инициализации кластера

- kubectl – утилита командной строки для управления кластером

Процесс установки различается в зависимости от операционной системы. Для Linux-систем (Ubuntu/CentOS) процедура выглядит следующим образом:

# Добавление репозитория Kubernetes curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add - sudo apt-add-repository "deb http://apt.kubernetes.io/ kubernetes-xenial main" # Установка необходимых компонентов sudo apt-get update sudo apt-get install -y kubelet kubeadm kubectl

Для Windows и macOS рекомендуется использовать Docker Desktop с включенной поддержкой Kubernetes или специализированные решения вроде Minikube.

Особое внимание следует уделить настройке сетевого взаимодействия между компонентами кластера. Здесь мы сталкиваемся с необходимостью правильной конфигурации DNS и обеспечения корректной маршрутизации между подами.

После базовой установки необходимо выполнить инициализацию кластера:

sudo kubeadm init --pod-network-cidr=10.244.0.0/16

Далее следует настройка сетевого плагина (например, Flannel или Calico) для обеспечения коммуникации между подами в кластере.

Важно отметить, что при развертывании в production-среде необходимо уделить особое внимание вопросам безопасности и отказоустойчивости. Рекомендуется использовать минимум три master-ноды для обеспечения высокой доступности control plane.

Процесс установки может показаться сложным, особенно для начинающих. Именно поэтому для локальной разработки и тестирования существуют упрощенные решения, о которых мы поговорим в следующем разделе.

Использование Minikube для локальной разработки

В процессе изучения и тестирования Kubernetes мы часто сталкиваемся с необходимостью быстрого развертывания локального окружения. Именно здесь на помощь приходит Minikube – легковесное решение для создания локального кластера Kubernetes на одной машине.

Minikube предоставляет удобный способ запуска однонодового кластера Kubernetes в виртуальной машине, что особенно ценно для разработчиков и тестировщиков. Основные преимущества этого инструмента включают:

- Простота установки и использования

- Минимальные требования к ресурсам

- Поддержка большинства функций полноценного Kubernetes

- Возможность быстрого перезапуска и очистки окружения

Однако следует учитывать и определенные ограничения:

- Невозможность тестирования сценариев масштабирования на несколько нод

- Ограниченная производительность

- Отсутствие некоторых продвинутых функций enterprise-версии Kubernetes

Запуск Minikube осуществляется простой командой:

minikube start

Этот инструмент становится незаменимым для локальной разработки и обучения, но не стоит забывать, что реальные production-среды требуют более комплексного подхода к развертыванию и управлению кластером.

Развертывание приложений

В современной практике развертывания приложений мы наблюдаем значительный сдвиг парадигмы от традиционных монолитных систем к микросервисной архитектуре. Kubernetes предоставляет мощный инструментарий для управления этим процессом, делая его более предсказуемым и контролируемым.

Процесс развертывания приложения в Kubernetes включает несколько ключевых этапов:

- Подготовка манифестов:

apiVersion: apps/v1

kind: Deployment

metadata:

name: example-app

spec:

replicas: 3

selector:

matchLabels:

app: example

template:

metadata:

labels:

app: example

spec:

containers:

- name: example-container

image: example-image:latest

ports:

- containerPort: 8080

- Создание объектов в кластере:

kubectl apply -f deployment.yaml

- Настройка сетевого доступа через Service:

apiVersion: v1

kind: Service

metadata:

name: example-service

spec:

selector:

app: example

ports:

- port: 80

targetPort: 8080

type: LoadBalancer

Особое внимание следует уделить стратегиям развертывания. Kubernetes поддерживает несколько подходов:

- Rolling Update (постепенное обновление)

- Blue-Green deployment (параллельное развертывание новой версии)

- Canary deployment (тестирование на части трафика)

При выборе стратегии необходимо учитывать специфику приложения и требования к доступности сервиса. Например, для критически важных систем рекомендуется использовать более консервативные подходы с возможностью быстрого отката.

Важным аспектом является также управление конфигурацией приложения через ConfigMaps и Secrets:

apiVersion: v1 kind: ConfigMap metadata: name: app-config data: database_url: "postgres://localhost:5432/db" api_key: "development_key"

Это позволяет отделить конфигурацию от кода и гибко управлять параметрами приложения в различных окружениях.

Нельзя не отметить важность правильного управления ресурсами. Установка лимитов и запросов ресурсов помогает предотвратить ситуации, когда одно приложение может повлиять на работу других:

resources:

requests:

memory: "64Mi"

cpu: "250m"

limits:

memory: "128Mi"

cpu: "500m"

Особого внимания заслуживает вопрос персистентности данных. Для приложений, требующих хранения состояния, Kubernetes предоставляет механизм Persistent Volumes и Persistent Volume Claims, что позволяет абстрагировать хранение данных от конкретной инфраструктуры.

В контексте микросервисной архитектуры важно также правильно организовать взаимодействие между сервисами, используя внутренние DNS-имена и service discovery механизмы Kubernetes. Но как же убедиться, что все компоненты работают корректно? Об этом поговорим в следующем разделе, посвященном мониторингу и логированию.

Мониторинг и логирование

В мире распределенных систем мониторинг и логирование становятся не просто полезными инструментами, а критически важными компонентами инфраструктуры. Kubernetes предоставляет богатый набор возможностей для отслеживания состояния кластера и приложений, но требует правильного подхода к их организации.

Основные инструменты мониторинга в экосистеме Kubernetes включают:

- Prometheus – для сбора метрик и алертинга

- Grafana – для визуализации метрик

- Elasticsearch-Fluentd-Kibana (EFK) стек – для централизованного сбора логов

- Kubernetes Dashboard – для визуального контроля состояния кластера

Базовый мониторинг можно настроить с помощью встроенных метрик:

kubectl top nodes kubectl top pods

Однако для production-среды рекомендуется использовать более комплексное решение. Типичная архитектура мониторинга включает:

- Сборщики метрик на каждой ноде

- Центральное хранилище метрик

- Систему визуализации

- Систему оповещений

Особое внимание стоит уделить настройке алертинга. Важно найти баланс между своевременным обнаружением проблем и избыточным количеством уведомлений, которые могут привести к «усталости от алертов» у команды поддержки.

При построении системы мониторинга следует помнить о принципе «золотых сигналов» Google SRE:

- Латентность

- Трафик

- Ошибки

- Насыщение (saturation)

Это помогает сфокусироваться на действительно важных метриках и не утонуть в море данных.

Примеры использования в реальных проектах

Теоретическое понимание Kubernetes, безусловно, важно, но реальная ценность этой технологии наиболее ярко проявляется при рассмотрении конкретных примеров внедрения. Рассмотрим несколько показательных кейсов из разных отраслей.

Финтех-сектор

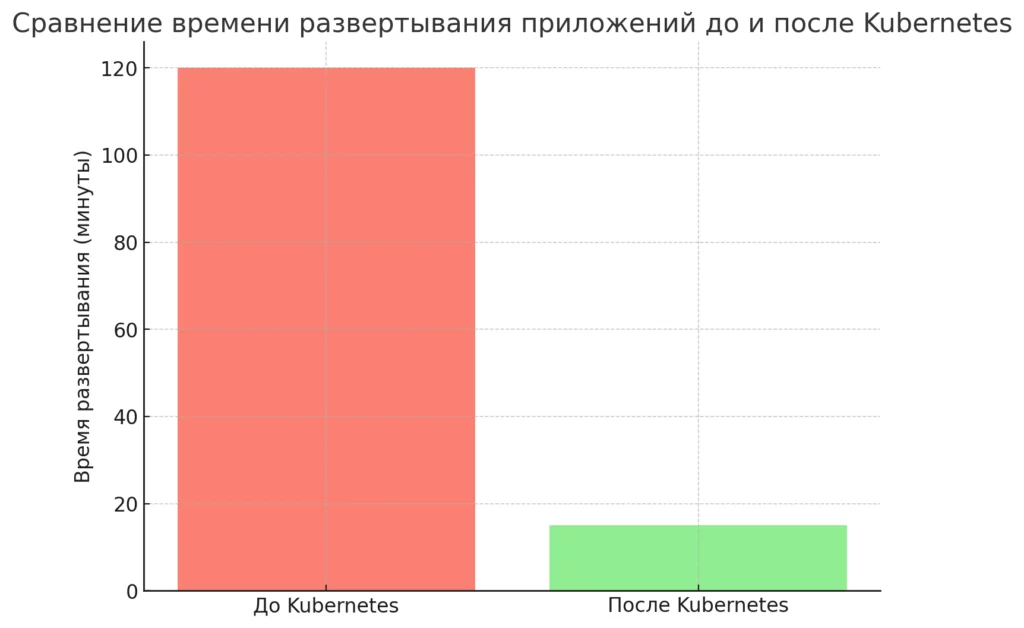

Крупный платежный сервис столкнулся с проблемой масштабирования во время пиковых нагрузок. После миграции на Kubernetes удалось достичь следующих результатов:

- Автоматическое масштабирование под нагрузкой

- Сокращение времени развертывания с часов до минут

- Повышение отказоустойчивости системы

- Снижение операционных расходов на 30%

E-commerce платформа

Интернет-магазин с миллионами ежедневных посещений использовал Kubernetes для:

- Обработки сезонных пиков продаж

- Управления микросервисной архитектурой (более 200 сервисов)

- Оптимизации использования ресурсов облачной инфраструктуры

Медиа-компания

Стриминговый сервис применил Kubernetes для:

- Распределения нагрузки по географически распределенным дата-центрам

- Оптимизации доставки контента

- Автоматического масштабирования при премьерах популярного контента

Интересен опыт внедрения в каждом случае. Например, финтех-компания начала с миграции некритичных сервисов, постепенно переводя все больше рабочих нагрузок в Kubernetes. Это позволило команде набраться опыта и минимизировать риски.

Особого внимания заслуживает подход к организации процесса развертывания:

apiVersion: apps/v1

kind: Deployment

metadata:

name: payment-service

spec:

replicas: 3

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 1

maxUnavailable: 0

Этот пример демонстрирует настройку безопасного обновления сервиса без простоев.

В каждом случае команды сталкивались с уникальными вызовами. Например, e-commerce платформа решала проблему сохранения состояния корзин покупателей при масштабировании, а медиа-компания оптимизировала доставку контента с учетом географического расположения пользователей.

Столбчатая диаграмма, которая иллюстрирует сравнение времени развертывания приложений до и после внедрения Kubernetes

Общие паттерны успешного внедрения включают:

- Постепенную миграцию

- Тщательное планирование архитектуры

- Инвестиции в обучение команды

- Автоматизацию процессов развертывания и тестирования

Эти примеры показывают, что Kubernetes может эффективно решать различные бизнес-задачи, но требует продуманного подхода к внедрению. Однако возникает вопрос: как обеспечить безопасность в такой распределенной среде?

Безопасность в Kubernetes

В эпоху участившихся кибератак и растущих требований к защите данных вопросы безопасности Kubernetes приобретают первостепенное значение. Мы наблюдаем, как простая ошибка в конфигурации может привести к серьезным последствиям для бизнеса.

Основные аспекты безопасности Kubernetes включают:

- Управление доступом:

apiVersion: rbac.authorization.k8s.io/v1 kind: Role metadata: name: pod-reader rules: - apiGroups: [""] resources: ["pods"] verbs: ["get", "list"]

- Сетевые политики:

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: default-deny

spec:

podSelector: {}

policyTypes:

- Ingress

- Управление секретами:

- Использование внешних систем управления секретами (HashiCorp Vault, AWS Secrets Manager)

- Шифрование данных в состоянии покоя

- Регулярная ротация ключей

Ключевые рекомендации по безопасности:

- Минимизация привилегий для сервисных аккаунтов

- Регулярное обновление компонентов кластера

- Использование Pod Security Policies

- Мониторинг подозрительной активности

- Изоляция рабочих нагрузок

Особое внимание следует уделить соответствию регуляторным требованиям (GDPR, PCI DSS) при работе с чувствительными данными.

Преимущества и недостатки Kubernetes

В мире технологий редко встречаются универсальные решения, и Kubernetes не является исключением. Проанализируем основные преимущества и потенциальные сложности, с которыми сталкиваются команды при внедрении этой платформы.

Преимущества:

- Автоматизация управления:

- Автоматическое восстановление после сбоев

- Самостоятельное масштабирование под нагрузкой

- Автоматическое распределение нагрузки

- Гибкость и переносимость:

- Поддержка различных облачных провайдеров

- Возможность гибридных развертываний

- Независимость от инфраструктуры

- Экономическая эффективность:

- Оптимизация использования ресурсов

- Снижение операционных затрат

- Уменьшение времени простоя

Недостатки:

- Сложность освоения:

- Крутая кривая обучения

- Необходимость глубокого понимания системы

- Сложность отладки проблем

- Ресурсоемкость:

- Высокие требования к инфраструктуре

- Дополнительные накладные расходы

- Необходимость выделения ресурсов на системные компоненты

- Операционные вызовы:

- Сложность первоначальной настройки

- Необходимость постоянного мониторинга

- Риски при неправильной конфигурации

Важно отметить, что многие из указанных недостатков можно минимизировать при правильном планировании и подготовке команды. Возникает вопрос: как же Kubernetes соотносится с альтернативными решениями на рынке?

Сравнение с другими платформами

В контексте оркестрации контейнеров мы наблюдаем активное развитие различных решений, каждое из которых имеет свои особенности. Проведем сравнительный анализ Kubernetes с основными альтернативами.

Docker Swarm

- Преимущества:

- Более простая установка и настройка

- Нативная интеграция с Docker

- Меньше накладных расходов

- Недостатки:

- Ограниченная функциональность

- Меньше возможностей для масштабирования

- Менее развитая экосистема

Apache Mesos

- Преимущества:

- Высокая производительность

- Поддержка не только контейнеров

- Хорошая масштабируемость

- Недостатки:

- Сложная архитектура

- Меньше готовых решений

- Требует больше ресурсов

OpenShift (основан на Kubernetes)

- Преимущества:

- Дополнительный уровень безопасности

- Встроенные CI/CD инструменты

- Корпоративная поддержка от Red Hat

- Недостатки:

- Высокая стоимость

- Vendor lock-in

- Дополнительная сложность

При выборе платформы следует учитывать специфику проекта, имеющиеся ресурсы и компетенции команды. В большинстве случаев Kubernetes предоставляет оптимальный баланс между функциональностью и сложностью, что объясняет его лидирующие позиции на рынке.

Заключение

В ходе нашего подробного анализа мы рассмотрели Kubernetes как комплексное решение для управления контейнеризированными приложениями. Подобно тому, как в свое время виртуализация изменила подход к использованию серверных ресурсов, Kubernetes трансформирует способы развертывания и управления современными приложениями.

Ключевые выводы, которые мы можем сделать:

- Kubernetes стал де-факто стандартом в области оркестрации контейнеров, предлагая богатый функционал для автоматизации развертывания и управления приложениями

- Несмотря на относительную сложность освоения, инвестиции в изучение этой технологии окупаются за счет повышения эффективности работы команд и оптимизации использования ресурсов

- Экосистема Kubernetes продолжает активно развиваться, предлагая все новые инструменты и решения для различных сценариев использования

В перспективе мы можем ожидать дальнейшего развития платформы в направлении упрощения управления и расширения функциональности для edge-computing и гибридных облачных решений.

Для структурированного изучения Kubernetes и смежных технологий рекомендуем обратить внимание на специализированные образовательные программы. На странице подборки курсов системного администратора вы найдете актуальные учебные материалы, которые помогут освоить как базовые концепции, так и продвинутые техники работы с контейнерной оркестрацией. Многие курсы включают практические задания и работу с реальными проектами, что особенно ценно для закрепления полученных знаний.

Для тех, кто планирует начать работу с Kubernetes, рекомендуем:

- Начать с локального окружения на базе Minikube

- Уделить особое внимание изучению основных концепций и компонентов

- Постепенно наращивать сложность решаемых задач

- Активно участвовать в сообществе и следить за новыми разработками

Kubernetes – это не просто технология, а целая экосистема, которая продолжает эволюционировать вместе с развитием облачных технологий и практик DevOps. И хотя путь освоения может показаться сложным, результаты определенно стоят затраченных усилий.

Геймификация в обучении: что это такое, зачем нужна и как внедрить

Геймификация это не просто развлечение, а рабочий инструмент образования. Хотите понять, какие механики работают лучше всего и как внедрить их без ошибок?

Профессиональные компетенции: как оценить и развить навыки сотрудников для успеха бизнеса

Что скрывается за понятием «профессиональные компетенции» и почему оно стало ключевым для современного бизнеса? В этом материале мы просто и по существу разберёмся, какие навыки важны сегодня, как их оценивать и развивать на практике.

Flutter — что это такое и как создать первое мобильное приложение

Интересуетесь, flutter что это и как он помогает создавать мобильные приложения быстрее? В материале вы найдёте ответы простыми словами и узнаете, как собрать первый проект.

Как удалить дубликаты в Excel и Google Таблицах: полное руководство с примерами

Хотите разобраться, как удалить дубликаты в Excel быстро и без лишних шагов? В этой статье вы узнаете, почему таблицы «засоряются», какие инструменты работают наиболее эффективно и как избежать появления дублей в будущем. Мы собрали практичные советы и примеры, которые помогут вам очистить данные без ошибок.