Как оркестрация контейнеров упрощает управление

Представьте, что вы — дирижер огромного оркестра, где каждый музыкант играет в отдельной звуконепроницаемой кабинке (да, весьма специфический оркестр). Ваша задача — не просто заставить их играть синхронно, но и решать, кому играть громче, кому тише, а кому и вовсе взять перерыв, когда партия не нужна. Примерно так работает и оркестрация контейнеров — только вместо музыкантов у нас контейнеры с приложениями, а вместо дирижера — специальное программное обеспечение.

В современном мире разработки, где приложения часто напоминают сложный конструктор из множества компонентов, оркестрация контейнеров стала не просто модным словом в резюме DevOps-инженера, а насущной необходимостью. Она помогает автоматизировать развертывание, масштабирование и управление контейнеризированными приложениями. На рынке сейчас правят бал три основных игрока: Kubernetes (для друзей просто K8s), Docker Swarm (встроенный оркестратор Docker) и Nomad от HashiCorp. Каждый из них, как истинный дирижер, имеет свой уникальный стиль управления оркестром контейнеров.

- Kubernetes

- Docker Swarm

- Nomad

- Балансировка нагрузки и восстановление после сбоев

- Примеры внедрения и использования

- CI/CD и автоматизация

- Выбор подходящего оркестратора

- Сравнение производительности и удобства использования

Kubernetes

Kubernetes (или K8s, для тех, кто не любит печатать длинные слова) — это своего рода «тяжелая артиллерия» в мире оркестрации контейнеров. Представьте себе швейцарский армейский нож, который каким-то образом еще и самостоятельно учится новым функциям — примерно такова суть этого инструмента, который был разработан Google и с самого начала выпущен как открытый проект под эгидой Cloud Native Computing Foundation.

Архитектура K8s напоминает военную иерархию — есть Control Plane (главнокомандующий), который включает в себя несколько ключевых компонентов: kube-api-server (министр связи), kube-controller-manager (начальник генштаба), kube-scheduler (квартирмейстер) и etcd (архив с совершенно секретными документами). На передовой находятся рабочие узлы (nodes), где kubelet и kube-proxy делают всю грязную работу по управлению контейнерами и настройке сетевого взаимодействия.

Что же касается возможностей — тут K8s разворачивается во всей красе. Автоматическое масштабирование? Пожалуйста. Самовосстановление после сбоев? Без проблем. Балансировка нагрузки? Да запросто! Причем все это можно настроить с помощью декларативных конфигураций — просто опишите желаемое состояние системы, а K8s сам разберется, как его достичь (хотя, признаюсь, иногда его представление о «желаемом состоянии» может вызвать легкое недоумение).

Но есть и подводные камни (куда же без них). Главный из них — сложность. Кривая обучения K8s больше напоминает отвесную скалу, чем плавный подъем. Плюс ко всему, для его работы требуется солидное количество ресурсов — так что если вы думали запустить его на raspberry pi для домашнего проекта, возможно, стоит подумать дважды.

Зато у K8s есть то, чего не хватает многим другим технологиям — огромное и активное сообщество. Можно сказать, что это своего рода социальная сеть для DevOps-инженеров, только вместо фотографий котиков там обсуждают yaml-манифесты и проблемы с pod’ами (хотя иногда котики тоже проскакивают — куда же без них в IT).

Docker Swarm

А теперь поговорим о Docker Swarm — этаком «младшем брате» в семействе оркестраторов. Представьте, что Kubernetes — это навороченный смартфон с кучей функций, тогда Docker Swarm — это кнопочная Nokia: делает меньше, но то, что делает — делает надежно. И главное — батарейка держит долго (читай: ресурсов жрет немного).

Архитектура Swarm подкупает своей простотой — всего два типа узлов: менеджеры (bosses) и рабочие (workers). Менеджеры определяют, где и как будут работать контейнеры, а рабочие… ну, работают. Прямо как в офисе среднестатистической компании, не правда ли? Минимальная рабочая единица здесь — Service, который разбивается на tasks, в каждом из которых крутится Docker-контейнер (и только Docker — никаких измен с другими системами контейнеризации).

Запустить Swarm проще простого — буквально пара команд в терминале:

docker swarm init --advertise-addr 192.168.99.100 docker swarm join --token %sometoken% 192.168.99.100:2377

И вуаля — ваш оркестратор готов! Никаких тебе сложных настроек, трехтомных руководств по установке и ритуальных танцев с бубном вокруг сервера.

Но, как говорится, за все в жизни надо платить. В случае со Swarm платой за простоту стали довольно существенные ограничения. Автоматическое масштабирование? Извините, только ручками через replicas. Стратегии обновления? Есть несколько вариантов — rolling updates для постепенного обновления, recreation для полной замены сервиса, но всё равно не такой богатый выбор, как у K8s. Работа с чем-то кроме Docker-контейнеров? Даже не мечтайте.

А еще есть один момент, который заставляет задуматься — сообщество. Точнее, его практическое отсутствие. Помните фразу «Docker Swarm мертв»? Она не просто так появилась. Когда у вас возникнет проблема (а она возникнет, поверьте), найти решение может оказаться сложнее, чем отыскать иголку в стоге сена. Причем иголку хотя бы можно найти магнитом, а вот с решением придется повозиться.

Так что если вы ищете что-то простое и легковесное для небольшого проекта — Docker Swarm может быть неплохим выбором. Но помните: простота — палка о двух концах, и второй конец может больно ударить, когда проект начнет расти.

Nomad

А теперь поговорим о Nomad от HashiCorp — этаком «фрилансере» среди оркестраторов. В отличие от своих коллег, которые специализируются исключительно на контейнерах, Nomad готов взяться практически за любую работу: Docker-контейнеры? Легко! Виртуальные машины? Без проблем! Java-приложения? Давайте сюда! А еще он прекрасно работает в облачной инфраструктуре AWS, хотя и является конкурентом их собственного решения ECS.

Архитектура Nomad напоминает упрощенную версию Kubernetes (только не говорите об этом K8s-энтузиастам). Есть серверы, которые, как опытные HR-менеджеры, решают, кому и где работать, и клиенты, которые, как прилежные сотрудники, выполняют порученную работу. Вместо подов здесь jobs (работы), которые описываются на специфическом языке HCL (HashiCorp Configuration Language). Да, еще один язык конфигурации, потому что YAML и JSON нам, видимо, было недостаточно.

job "example-job" {

type = "service"

group "example-group" {

count = 3

task "example-task" {

driver = "docker"

config {

image = "nginx:latest"

}

}

}

}

Особая прелесть Nomad в том, что он прекрасно дружит со всей экосистемой HashiCorp: Vault хранит секреты, Consul занимается service discovery, а Terraform управляет инфраструктурой. Прямо как большая и дружная семья, где каждый занимается своим делом, но все работают на общее благо.

Но есть и подвох (а когда его не было?). Многие «из коробки» функции, которые есть у других оркестраторов, в Nomad либо отсутствуют, либо доступны только в Enterprise-версии. Хотите автоматическое масштабирование? Придется раскошелиться. Load balancing? Тоже платите. И сообщество здесь не такое большое, как у K8s, хотя и активнее, чем у Docker Swarm (что, впрочем, не так уж сложно).

Зато Nomad нетребователен к ресурсам (привет, raspberry pi энтузиасты!) и прост в установке. А еще он может мирно сосуществовать с Kubernetes — этакий пример технологической дипломатии в действии. Можно даже запускать некоторые jobs прямо в K8s, если вы вдруг почувствуете ностальгию по более привычному окружению.

Балансировка нагрузки и восстановление после сбоев

Помните старую поговорку «Надежда на лучшее, готовность к худшему»? В мире оркестрации контейнеров мы немного переиначим её: «Надейся на автоматику, но держи под рукой консоль». Давайте разберем, как наши оркестраторы справляются с двумя критически важными задачами: распределением нагрузки и восстановлением после сбоев (спойлер: одни лучше, другие… ну, пытаются).

Kubernetes, как настоящий перфекционист, подходит к этому вопросу со всей серьезностью. Представьте себе очень внимательного администратора отеля, который постоянно следит, чтобы все номера были равномерно заняты, а если вдруг где-то прорвало трубу — мгновенно переселяет постояльцев в другие комнаты. Примерно так работает и K8s:

apiVersion: v1

kind: Service

metadata:

name: my-service

spec:

selector:

app: my-app

ports:

- protocol: TCP

port: 80

targetPort: 9376

type: LoadBalancer

---

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-app

spec:

replicas: 3

strategy:

type: RollingUpdate

selector:

matchLabels:

app: my-app

В этом примере K8s не только распределит нагрузку между тремя репликами, но и автоматически перезапустит упавший под, причем так аккуратно, что пользователи даже не заметят проблемы (в теории, по крайней мере).

Docker Swarm в этом плане напоминает младшего брата, который во всем пытается подражать старшему, но получается… скажем так, по-своему:

version: "3"

services:

web:

image: nginx

deploy:

replicas: 3

update_config:

parallelism: 1

delay: 10s

restart_policy:

condition: on-failure

max_attempts: 3

Здесь тоже есть балансировка и восстановление, но всё немного проще. Swarm использует встроенный DNS round-robin для распределения запросов, а при сбое просто пытается перезапустить контейнер. Работает? Да. Элегантно? Ну, давайте скажем, что главное — результат.

Nomad, как всегда, идет своим путем:

job "webapp" {

group "frontend" {

count = 3

spread {

attribute = "${node.datacenter}"

}

task "nginx" {

driver = "docker"

config {

image = "nginx:latest"

}

service {

name = "webapp"

port = "http"

check {

type = "http"

path = "/"

interval = "10s"

timeout = "2s"

}

}

}

}

}

Здесь мы видим интересный подход: Nomad может использовать Consul для service discovery и балансировки нагрузки, а также имеет встроенные механизмы для распределения задач по разным дата-центрам. При сбое он также автоматически перепланирует задачи, хотя и не так агрессивно, как Kubernetes.

На практике выбор механизма восстановления часто зависит от специфики приложения. Например, для stateless-сервисов можно использовать агрессивную стратегию с быстрым перезапуском, а для баз данных нужен более осторожный подход. Как говорится, «семь раз отмерь, один раз задеплой».

Интересный факт: согласно исследованиям, большинство сбоев в продакшене происходит не из-за отказа самих приложений, а из-за проблем с конфигурацией систем восстановления. Ирония? Возможно. Повод внимательнее относиться к настройке этих механизмов? Определенно!

Теперь, когда мы разобрались с тем, как наши оркестраторы справляются с неприятностями, давайте посмотрим на реальные примеры их внедрения и использования…

Примеры внедрения и использования

Итак, вы решили погрузиться в мир оркестрации контейнеров. Давайте посмотрим, как это работает на практике — без розовых очков маркетологов и страшилок из серии «все пропало, ничего не получится».

Начнем с Kubernetes, потому что… ну, это же Kubernetes! Типичный сценарий внедрения обычно выглядит примерно так:

apiVersion: apps/v1

kind: Deployment

metadata:

name: my-super-app

spec:

replicas: 3

selector:

matchLabels:

app: super-app

template:

spec:

containers:

- name: main

image: my-registry/super-app:latest

resources:

requests:

memory: "64Mi"

cpu: "250m"

limits:

memory: "128Mi"

cpu: "500m"

И это только начало! Добавьте сюда сервисы, ингрессы, конфигмапы, секреты — и получите типичный «Hello, World!» в корпоративном стиле.

Docker Swarm, в свою очередь, порадует вас более лаконичным синтаксисом:

version: "3"

services:

web:

image: nginx:latest

deploy:

replicas: 3

resources:

limits:

cpus: '0.5'

memory: 128M

Выглядит проще, правда? Только не обольщайтесь — эта простота может дорого обойтись при масштабировании.

А вот как выглядит типичный job в Nomad:

job "web-app" {

datacenters = ["dc1"]

type = "service"

group "frontend" {

count = 3

task "nginx" {

driver = "docker"

config {

image = "nginx:latest"

}

resources {

cpu = 500

memory = 128

}

}

}

}

На практике внедрение любого из этих оркестраторов обычно проходит через несколько этапов:

- Стадия отрицания («Нам это не нужно»)

- Стадия гнева («Кто это придумал?!»)

- Стадия торга («Может, обойдемся чем попроще?»)

- Стадия депрессии («Ничего не работает…»)

- Стадия принятия («А ведь неплохо работает!»)

При этом важно помнить, что оркестрация — это не просто модное слово для резюме. Это реальный инструмент, который может значительно упростить жизнь команде разработки. Правда, перед этим он её изрядно усложнит — но это уже детали.

Один из моих любимых примеров — компания, которая начала с трех Docker-контейнеров на одном сервере, а закончила кластером Kubernetes с сотней узлов. Причем переход занял всего полгода — и это включая время на причитания «зачем мы в это ввязались» и «кто все это будет поддерживать».

CI/CD и автоматизация

Помните старые добрые времена, когда для деплоя приложения достаточно было закинуть пару файлов по FTP? Нет? Я тоже стараюсь это забыть. В современном мире CI/CD и оркестрация контейнеров — как инь и ян, только с большим количеством yaml-файлов и нервных тиков у DevOps-инженеров.

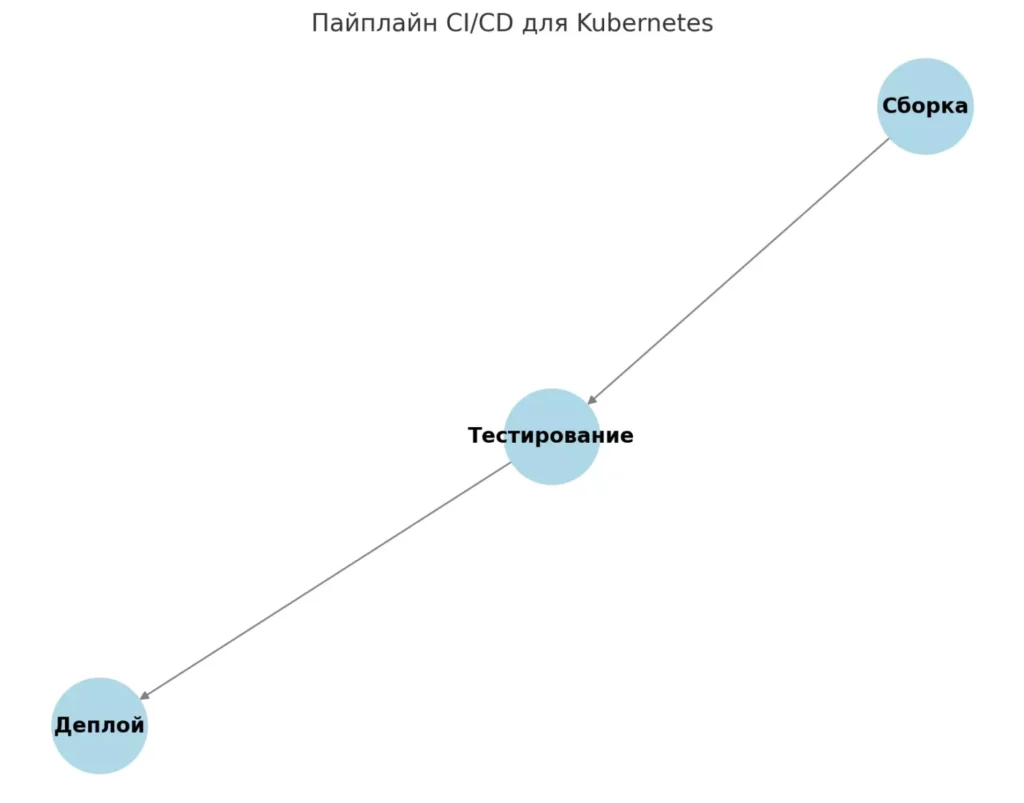

Давайте посмотрим, как это работает на практике. Вот типичный пайплайн для Kubernetes (спойлер: готовьтесь к обилию yaml):

# В вашем любимом CI-инструменте

stages:

- build

- test

- deploy

build:

stage: build

script:

- docker build -t my-awesome-app:${CI_COMMIT_SHA} .

- docker push my-awesome-app:${CI_COMMIT_SHA}

deploy:

stage: deploy

script:

- kubectl set image deployment/my-app container=${CI_COMMIT_SHA}

Выглядит просто? Ха! Это только верхушка айсберга. Добавьте сюда управление секретами, проверку уязвимостей, тестирование — и получите документ размером с «Войну и мир», только менее увлекательный.

Диаграмма пайплайна CI/CD для Kubernetes с этапами «Сборка», «Тестирование» и «Деплой»

Docker Swarm в этом плане попроще (как и во всем остальном):

docker stack deploy --compose-file docker-compose.yml my-stack

Одна строчка — и ваше приложение в продакшене. Правда, потом придется долго объяснять, почему все упало, но это уже детали.

А вот Nomad, как всегда, идет своим путем

job "webapp" {

group "frontend" {

task "server" {

driver = "docker"

config {

image = "webapp:${NOMAD_META_VERSION}"

}

}

}

}

Главное в автоматизации — помнить золотое правило: «Автоматизируйте все, что можно автоматизировать, но не забывайте, что где-то должна быть большая красная кнопка с надписью STOP». И да, я говорю это из личного опыта — поверьте, вам она пригодится.

Выбор подходящего оркестратора

Выбор оркестратора — это как выбор спутника жизни: решение серьезное, последствия долгосрочные, а развод будет болезненным и дорогим. Давайте попробуем разобраться, кому что подходит (спойлер: скорее всего, вам нужен Kubernetes, но давайте сделаем вид, что у нас есть выбор).

Kubernetes — для тех, кто:

- Готов инвестировать время и деньги в обучение команды

- Планирует масштабироваться до космических масштабов

- Любит, когда «из коробки» есть всё (и даже больше, чем нужно)

- Не боится сложности и имеет достаточно ресурсов

- Хочет быть «как Google» (хотя, давайте честно, вы не Google)

Docker Swarm подойдет, если вы:

- Только начинаете знакомство с оркестрацией

- Имеете небольшой проект с простыми требованиями

- Уже используете Docker и не хотите усложнять жизнь

- Готовы мириться с ограничениями ради простоты

- Не планируете глобальное масштабирование в ближайшем будущем

Nomad — ваш выбор, когда:

- Нужна поддержка не только контейнеров

- Ресурсы ограничены (как человеческие, так и серверные)

- Хочется чего-то между простотой Swarm и мощью Kubernetes

- Уже используете другие продукты HashiCorp

- Готовы платить за enterprise-функции

И помните: какой бы оркестратор вы ни выбрали, всегда найдется кто-то, кто скажет, что вы сделали неправильный выбор. Обычно это тот самый человек, который пишет многостраничные посты на Reddit о преимуществах своего любимого инструмента.

Конечно, разобраться во всех этих технологиях самостоятельно — задача не из простых. Как говорится, «дьявол кроется в деталях», а в мире оркестрации контейнеров этих деталей хватит на несколько томов технической документации. Если вы чувствуете, что вам нужно более структурированное обучение, на KursHub собрана подборка курсов по системному администрированию и DevOps практикам, где можно найти программы разного уровня сложности — от базового знакомства с контейнеризацией до глубокого погружения в Kubernetes и другие инструменты оркестрации. А теперь давайте сравним наши оркестраторы по производительности и удобству использования…

Сравнение производительности и удобства использования

Давайте устроим небольшой баттл между нашими оркестраторами. Только без фанатизма — у каждого свои сильные стороны (хотя, кого я обманываю, мы все знаем, что Kubernetes победит).

Производительность:

- Kubernetes: как спортивный автомобиль — мощный, но требует много топлива (читай: ресурсов)

- Docker Swarm: как экономичный седан — не гоночный, зато бензин не жрёт

- Nomad: что-то среднее между ними, только еще и на газу может ездить (привет, не-Docker контейнеры!)

Удобство управления (спойлер: тут все сложно):

Kubernetes: kubectl apply -f deployment.yaml (+ 500 строк документации, чтобы понять, что пошло не так) Docker Swarm: docker stack deploy -c docker-compose.yml myapp (+ молитва, чтобы всё заработало) Nomad: nomad job run job.hcl (+ надежда, что вы правильно написали конфиг на HCL)

По поддержке сообщества расклад такой:

- Kubernetes: огромное комьюнити, тонны документации, Stack Overflow завален вопросами

- Docker Swarm: «А это еще кто-то использует?»

- Nomad: небольшое, но преданное сообщество (в основном те, кто разочаровался в K8s)

В плане масштабируемости:

- Kubernetes: «Небо не предел!» (если у вас достаточно денег на железо)

- Docker Swarm: «Давайте будем реалистами…»

- Nomad: «Мы можем! Но за отдельную плату…»

В конце концов, выбор оркестратора — это всегда компромисс между функциональностью, простотой и стоимостью владения. Как говорится, хочешь получить все и сразу — готовься потратить много времени на изучение Kubernetes. Хочешь просто, чтобы работало — Docker Swarm к твоим услугам. А если хочется чего-то особенного — есть Nomad, только не забудь прочитать мелкий шрифт в лицензионном соглашении Enterprise-версии.

Лучшие языки для серверной разработки: что выбрать?

Серверная часть требует надежного инструмента. В статье вы найдете информацию о языках, которые делают бэкенд эффективным и безопасным, включая Python, Java, Node.js и Go.

Data Lineage: что это такое, зачем нужен и как внедрить

Что такое data lineage и почему без него сложно управлять современными потоками информации? В статье вы найдёте объяснения простыми словами, узнаете о преимуществах и получите практические советы по внедрению.

Bluetooth в iOS — мощно, гибко, но с подводными камнями

Какие подводные камни ждут iOS-разработчика при работе с bluetooth? В статье — примеры кода, советы по оптимизации и реальные кейсы.