Что такое Apache Airflow и зачем он нужен

В мире современных данных компании сталкиваются с растущей сложностью обработки информации. Представьте себе ситуацию: каждый день нужно загружать данные из различных источников, обрабатывать их, создавать отчеты и отправлять результаты заинтересованным сторонам. Вручную управлять такими процессами становится невозможно.

Apache Airflow — это платформа с открытым исходным кодом, которая решает проблему оркестрации данных. По сути, это дирижер оркестра, который координирует выполнение сложных рабочих процессов. Airflow позволяет описать последовательность задач, их зависимости и расписание выполнения, а затем автоматически запускает их в нужном порядке.

Зачем это нужно бизнесу? Автоматизация процессов обработки данных экономит время, снижает количество ошибок и обеспечивает предсказуемость результатов. Для разработчиков Airflow предоставляет гибкий инструмент для создания и поддержки ETL-процессов (Extract, Transform, Load), которые являются основой современной аналитики данных.

- Основные возможности Apache Airflow

- Как устроен Apache Airflow — ключевые компоненты

- Пример работы Apache Airflow на практике

- Преимущества Apache Airflow

- Недостатки Apache Airflow и сложности внедрения

- Кому подойдёт Apache Airflow

- Какие навыки нужны для работы с Airflow

- Альтернативы Apache Airflow

- Заключение

- Рекомендуем посмотреть курсы по системной аналитике

Основные возможности Apache Airflow

Apache Airflow предлагает комплексное решение для управления процессами обработки данных. Рассмотрим ключевые возможности этой платформы.

Оркестрация данных — основная функция Airflow. Система позволяет определить сложные рабочие процессы как направленные ациклические графы (DAG), где каждая задача имеет четко определенные зависимости от других. Это обеспечивает правильный порядок выполнения операций и предотвращает возникновение циклических зависимостей.

Автоматизация ETL-процессов становится значительно проще благодаря богатой библиотеке операторов. Airflow может извлекать данные из различных источников — от традиционных баз данных до облачных сервисов, трансформировать их с помощью Python-кода или SQL-запросов, а затем загружать в целевые системы.

Планирование задач осуществляется с помощью гибкого планировщика, который поддерживает как временные расписания, так и запуск по событиям. Можно настроить ежедневные, еженедельные или более сложные расписания выполнения.

Мониторинг выполнения реализован через удобный веб-интерфейс, который позволяет отслеживать статус задач в реальном времени, анализировать историю выполнения и быстро выявлять проблемы в рабочих процессах.

Как устроен Apache Airflow — ключевые компоненты

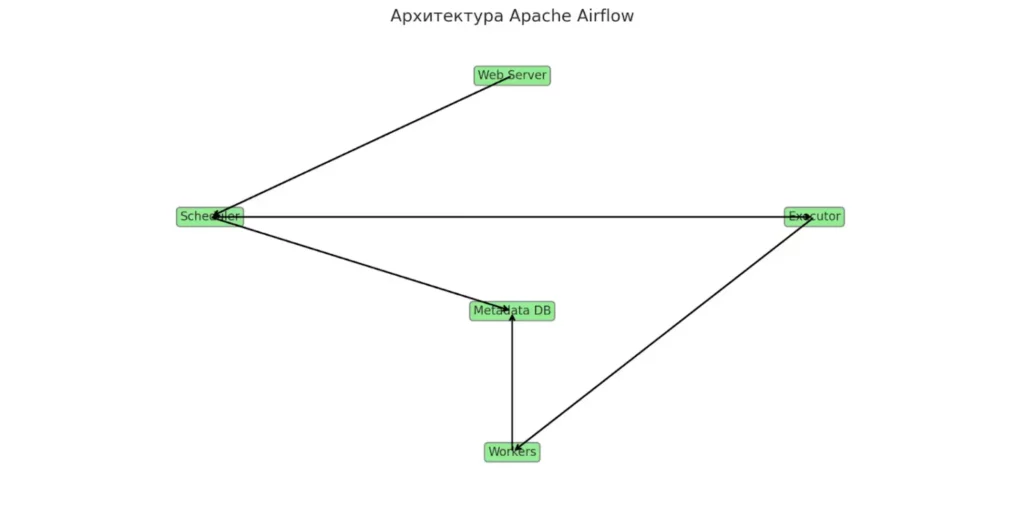

Чтобы эффективно использовать Apache Airflow, необходимо понимать его архитектуру и основные компоненты. Давайте разберем каждый элемент системы.

Схема архитектуры Airflow: взаимодействие компонентов — от Web Server до Executor и Workers.

DAG (Directed Acyclic Graph)

DAG — это сердце Airflow, которое описывает логику выполнения задач. По сути, это Python-скрипт, определяющий рабочий процесс как граф без циклов. В DAG указывается, какие задачи должны выполняться, в каком порядке и с какой периодичностью. Например, задача обработки данных не может начаться до завершения задачи их загрузки — именно такие зависимости и описывает DAG.

Tasks (Задачи)

Задача — это атомарная единица работы в рамках DAG. Каждая задача представляет собой конкретное действие: выполнение SQL-запроса, запуск Python-функции или отправка email-уведомления. Задачи связаны между собой зависимостями, определяя последовательность выполнения всего рабочего процесса.

Operators (Операторы)

Операторы определяют, что именно делает каждая задача. Airflow предоставляет богатую библиотеку встроенных операторов:

- BashOperator — для выполнения bash-команд.

- PythonOperator — для запуска Python-функций.

- SQLOperator — для выполнения SQL-запросов.

- EmailOperator — для отправки уведомлений.

- DockerOperator — для запуска контейнеров.

Sensor (Сенсоры)

Сенсоры — это специальный тип операторов, которые ожидают наступления определенных событий или условий. Например, FileSensor проверяет появление файла в определенной директории, а HttpSensor мониторит доступность веб-сервиса. Сенсоры позволяют создавать реактивные рабочие процессы.

Executor (Исполнитель)

Исполнитель определяет, как и где выполняются задачи:

- SequentialExecutor — выполняет задачи последовательно, подходит для разработки.

- LocalExecutor — позволяет параллельное выполнение на одной машине.

- CeleryExecutor — распределяет задачи по нескольким работникам, обеспечивает масштабируемость.

Metadata Database (База метаданных)

База данных хранит всю информацию о DAG’ах, задачах, их состоянии и истории выполнения. Это центральное хранилище метаданных, которое позволяет Airflow отслеживать прогресс и восстанавливать состояние после сбоев.

Web UI

Веб-интерфейс предоставляет визуальное представление рабочих процессов. Через него можно мониторить выполнение задач, просматривать логи, управлять расписанием и анализировать производительность системы.

Установка и начальная настройка Apache Airflow

Чтобы приступить к работе с Apache Airflow, необходимо развернуть базовую инфраструктуру. Хотя платформа мощная и гибкая, установка может показаться сложной без пошаговой инструкции. Разберем базовый процесс запуска Airflow в локальной среде.

Шаг 1. Подготовка окружения

Рекомендуется создать отдельное виртуальное окружение для работы с Airflow:

-m venv airflow_venv source airflow_venv/bin/activate # для Linux/macOS airflow_venv\Scripts\activate # для Windows

Шаг 2. Установка Apache Airflow

Официальный способ — через pip. Перед установкой нужно указать совместимую версию и набор провайдеров:

export AIRFLOW_VERSION=2.9.0

export PYTHON_VERSION="$(python --version | cut -d " " -f 2 | cut -d "." -f 1-2)"

export CONSTRAINT_URL="https://raw.githubusercontent.com/apache/airflow/constraints-${AIRFLOW_VERSION}/constraints-${PYTHON_VERSION}.txt"

pip install "apache-airflow==${AIRFLOW_VERSION}" --constraint "${CONSTRAINT_URL}"

Для Windows команды экспортирования переменных адаптируются через set.

Шаг 3. Инициализация базы данных

После установки необходимо инициализировать базу метаданных Airflow:

airflow db init

Это создаст таблицы и структуру для хранения DAG’ов, задач, логов и историй выполнения.

Шаг 4. Создание пользователя

Для доступа к веб-интерфейсу нужно создать учетную запись администратора:

airflow users create \ --username admin \ --firstname Admin \ --lastname User \ --role Admin \ --email admin@example.com

Шаг 5. Запуск сервисов

Теперь можно запустить web-сервер и планировщик:

airflow webserver --port 8080 airflow scheduler

После этого интерфейс Airflow будет доступен по адресу http://localhost:8080, где вы сможете визуально управлять DAG’ами, отслеживать выполнение задач и анализировать логи.

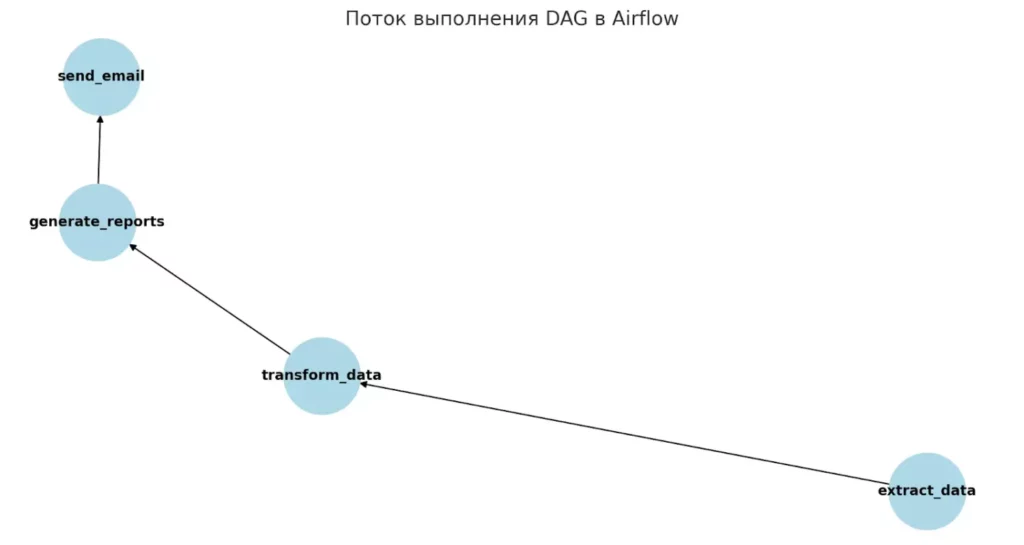

Пример работы Apache Airflow на практике

Рассмотрим реальный сценарий использования Airflow на примере компании розничной торговли, которая ежедневно обрабатывает данные о продажах.

Постановка задачи

Компании необходимо каждый день в 6:00 утра:

- Загрузить данные о продажах из различных источников (CRM, веб-аналитика, точки продаж).

- Очистить и трансформировать данные.

- Рассчитать ключевые метрики (выручка, конверсия, популярные товары).

- Создать отчеты в формате Excel и PDF.

- Отправить готовые отчеты менеджерам по email.

Такой процесс должен быть надежным, отказоустойчивым и легко модифицируемым.

Как это реализовать в Airflow

В Airflow этот процесс описывается как DAG с последовательными задачами:

from airflow import DAG from airflow.operators.python import PythonOperator from airflow.operators.bash import BashOperator from airflow.operators.email import EmailOperator # Создаем DAG с ежедневным расписанием dag = DAG( 'daily_sales_report', schedule_interval='0 6 * * *', # Каждый день в 6:00 start_date=datetime(2024, 1, 1) ) # Задачи выполняются последовательно extract_data = PythonOperator( task_id='extract_sales_data', python_callable=extract_from_sources, dag=dag ) transform_data = PythonOperator( task_id='transform_data', python_callable=clean_and_transform, dag=dag ) generate_reports = BashOperator( task_id='generate_reports', bash_command='python /scripts/create_reports.py', dag=dag ) send_email = EmailOperator( task_id='send_reports', to=['manager@company.com'], subject='Daily Sales Report', html_content='Reports attached', dag=dag ) # Определяем зависимости extract_data >> transform_data >> generate_reports >> send_email

Граф выполнения DAG: каждая задача запускается строго после завершения предыдущей.

Airflow автоматически выполняет эти задачи в указанном порядке. Если какая-то задача завершается с ошибкой, система может автоматически повторить ее выполнение или уведомить администратора. Через веб-интерфейс можно в реальном времени отслеживать прогресс, просматривать логи и анализировать производительность каждого этапа.

Преимущества Apache Airflow

Apache Airflow предлагает ряд значительных преимуществ, которые делают его привлекательным выбором для организации рабочих процессов с данными.

Масштабируемость — одно из ключевых достоинств платформы. Airflow может обрабатывать как небольшие задачи стартапов, так и сложные корпоративные процессы с тысячами задач. Благодаря различным исполнителям (Executors) система легко адаптируется под растущие потребности бизнеса.

Поддержка отказоустойчивости обеспечивается встроенными механизмами восстановления. Если задача завершается с ошибкой, Airflow может автоматически повторить ее выполнение согласно настроенной политике retry. История выполнения сохраняется в базе метаданных, что позволяет восстанавливать процессы после сбоев.

Богатая экосистема операторов включает готовые интеграции с популярными сервисами: AWS, Google Cloud, Azure, Kubernetes, Docker, различными базами данных и системами мониторинга. Это значительно упрощает создание комплексных рабочих процессов.

Поддержка Python как основного языка разработки делает Airflow доступным для широкого круга разработчиков и data-инженеров. Все DAG’и пишутся на Python, что обеспечивает гибкость и возможность использования любых Python-библиотек.

Удобный Web-интерфейс предоставляет наглядное представление рабочих процессов в виде графов, детальную информацию о выполнении задач, логи и метрики производительности. Это облегчает мониторинг и отладку процессов.

Интеграция с облаками и БД позволяет легко подключать различные источники данных и целевые системы, создавая единую платформу для управления корпоративными данными.

Недостатки Apache Airflow и сложности внедрения

Несмотря на многочисленные преимущества, Apache Airflow имеет ряд ограничений, которые важно учитывать при планировании внедрения.

Требует настройки инфраструктуры — одна из основных сложностей. Для продуктивного использования необходимо правильно настроить базу данных, выбрать подходящий исполнитель, обеспечить мониторинг и логирование. Это требует значительных усилий DevOps-команды и может стать барьером для небольших проектов.

Сложность в поддержке кода вызывает неявная передача данных. Хотя последовательность выполнения задач в Airflow определяется строго и явно (например, задача_A >> задача_Б), потоки данных между ними менее очевидны. Это может усложнить отладку, так как не всегда интуитивно понятно, какая задача и какие данные передает следующей.

Нужно знание Python — обязательное требование для создания и модификации рабочих процессов. Хотя Python относительно прост в изучении, команды без опыта программирования могут столкнуться с трудностями при создании сложных DAG’ов.

Сложность в конфигурировании Executor’ов особенно проявляется при переходе от простых решений к масштабируемым. Настройка CeleryExecutor или KubernetesExecutor требует глубокого понимания архитектуры и может потребовать значительного времени на изучение и тестирование.

Неполная документация — характерная проблема многих open-source проектов. Некоторые аспекты работы системы могут быть недостаточно документированы, что усложняет процесс внедрения и решения нестандартных задач.

Эти ограничения не делают Airflow менее ценным инструментом, но требуют реалистичного планирования ресурсов и времени на внедрение.

Кому подойдёт Apache Airflow

Apache Airflow находит применение в различных ролях и командах, работающих с данными.

Инженеры данных — основная целевая аудитория Airflow. Для них платформа становится центральным инструментом проектирования, разработки и обслуживания систем обработки данных. Они используют Airflow для создания ETL-пайплайнов, управления потоками данных между различными системами и обеспечения качества данных.

Разработчики применяют Airflow для автоматизации процессов разработки и тестирования. Например, для автоматической загрузки тестовых данных, синхронизации между средами разработки и продакшена, или для управления процессами непрерывной интеграции.

Аналитики используют платформу для автоматизации создания отчетов, обновления аналитических витрин данных и подготовки данных для машинного обучения. Airflow помогает им сосредоточиться на анализе, а не на рутинных задачах по обработке данных.

DevOps-специалисты находят в Airflow решение для автоматизации инфраструктурных задач, мониторинга систем и управления процессами развертывания приложений.

Какие навыки нужны для работы с Airflow

Для эффективной работы с Apache Airflow необходим определенный набор технических навыков.

Основы Python — фундаментальное требование, поскольку все DAG’и пишутся на этом языке. Нужно понимать синтаксис, работу с функциями, классами и основными библиотеками. Глубокое знание Python не требуется, но уверенное владение базовыми концепциями критично для создания и поддержки рабочих процессов.

SQL — необходимый навык для работы с базами данных. Большинство задач обработки данных включают извлечение, трансформацию и загрузку информации из различных источников, что требует написания SQL-запросов. Понимание принципов работы с реляционными базами данных упростит создание эффективных пайплайнов.

Основы DevOps становятся важными при переходе к продуктивному использованию. Знание Docker поможет в контейнеризации задач и обеспечении изолированности процессов. Понимание Kubernetes будет полезно для масштабирования и управления большими рабочими нагрузками. Опыт работы с системами мониторинга и логирования также облегчит эксплуатацию Airflow в продакшене.

Начать изучение Airflow можно с базовых знаний Python и SQL — этого достаточно для создания простых рабочих процессов и понимания основных принципов работы платформы.

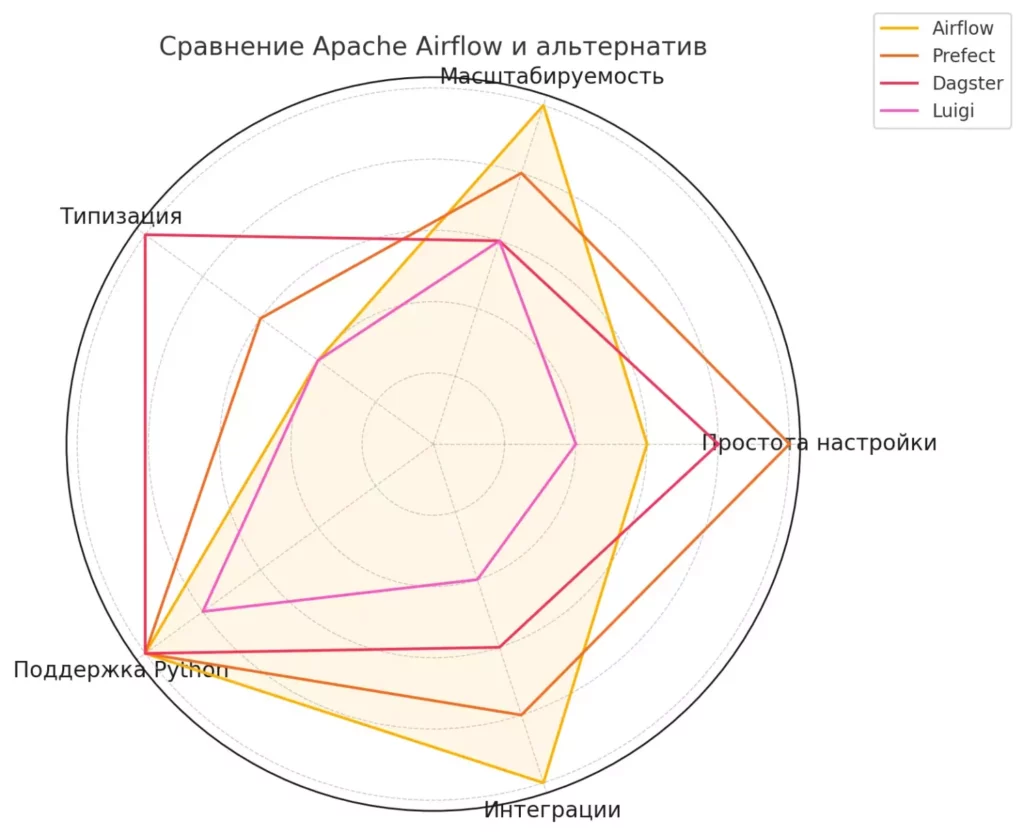

Альтернативы Apache Airflow

На рынке существует несколько альтернативных решений для оркестрации рабочих процессов с данными. Prefect предлагает более современный подход к определению потоков данных с акцентом на простоту использования и надежность. Luigi от Spotify фокусируется на создании сложных пайплайнов пакетной обработки данных. Dagster позиционируется как платформа нового поколения с улучшенной типизацией и тестируемостью процессов.

Каждое из этих решений имеет свои преимущества и может быть предпочтительным в определенных сценариях использования.

Радар-график визуализирует сравнение Airflow с другими популярными инструментами оркестрации данных. Видно, что Airflow лидирует по масштабируемости и экосистеме, но уступает в простоте настройки Prefect и типизации Dagster.

Заключение

Apache Airflow зарекомендовал себя как надежное и гибкое решение для автоматизации процессов обработки данных. Его сильные стороны — масштабируемость, богатая экосистема интеграций и активное сообщество разработчиков — делают его привлекательным выбором для проектов различного масштаба. Подведем итоги:

- Apache Airflow — это система для оркестрации данных. Она позволяет автоматизировать выполнение задач и строить сложные рабочие процессы.

- DAG — ключевая концепция платформы. Направленные графы определяют порядок и логику исполнения задач.

- Компоненты Airflow легко масштабируются. Благодаря различным Executor’ам платформа подходит как для стартапов, так и для корпораций.

- Внедрение требует подготовки. Настройка инфраструктуры и знание Python — обязательны для полноценной работы.

- У Airflow есть конкуренты. Prefect, Luigi и Dagster подойдут для других сценариев или меньших команд.

Если вы только начинаете осваивать новую профессию, рекомендуем обратить внимание на подборку курсов по системной аналитике. Они помогут вам не только понять теоретические основы платформы, но и закрепить навыки на практике: от построения DAG’ов до настройки пайплайнов под реальные задачи.

Рекомендуем посмотреть курсы по системной аналитике

| Курс | Школа | Цена | Рассрочка | Длительность | Дата начала | Ссылка на курс |

|---|---|---|---|---|---|---|

|

Аналитик данных

|

Eduson Academy

100 отзывов

|

Цена

Ещё -5% по промокоду

105 900 ₽

|

От

8 825 ₽/мес

Беспроцентная. На 1 год.

|

Длительность

6 месяцев

|

Старт

3 февраля

|

Подробнее |

|

Системный и бизнес-анализ в разработке ПО. Интенсив

|

Level UP

36 отзывов

|

Цена

75 000 ₽

|

От

18 750 ₽/мес

|

Длительность

1 месяц

|

Старт

6 февраля

|

Подробнее |

|

Системный аналитик PRO

|

Нетология

46 отзывов

|

Цена

с промокодом kursy-online

79 800 ₽

140 000 ₽

|

От

3 500 ₽/мес

Рассрочка на 2 года.

|

Длительность

10 месяцев

|

Старт

13 февраля

|

Подробнее |

|

Системный аналитик с нуля

|

Stepik

33 отзыва

|

Цена

4 500 ₽

|

|

Длительность

1 неделя

|

Старт

в любое время

|

Подробнее |

|

Системный аналитик с нуля до PRO

|

Eduson Academy

100 отзывов

|

Цена

Ещё -10% по промокоду

125 900 ₽

257 760 ₽

|

От

10 492 ₽/мес

10 740 ₽/мес

|

Длительность

6 месяцев

|

Старт

в любое время

|

Подробнее |

Как создать интерактивный прототип и не пожалеть?

Создание интерактивного прототипа — важный этап проектирования, который помогает выявить слабые места интерфейса и улучшить UX еще до начала разработки.

PostgreSQL — что это, зачем нужна и как начать пользоваться

Что такое PostgreSQL и почему её выбирают IT-гиганты? Разберёмся в особенностях, плюсах и минусах системы, научимся устанавливать и использовать СУБД с нуля.

Как вставить знак диаметра в Word и Excel

Вы не одиноки, если ищете, как поставить знак диаметра — ⌀ — в текст или таблицу. Рассказываем, какие есть способы и что работает быстрее всего.

Django — что это такое, как работает и зачем нужен разработчику

Django Python — что это и почему этот фреймворк так часто выбирают для крупных проектов? В статье разберём архитектуру, возможности и реальные сценарии применения, чтобы вы поняли, подходит ли он именно вам.