Docker-репозитории: полное руководство по работе, настройке и публикации образов

В современной разработке программного обеспечения Docker-репозиторий играет роль центрального хранилища образов — своеобразного склада, где содержатся готовые к использованию контейнеризированные приложения. По сути, это специализированное хранилище, которое позволяет разработчикам сохранять, версионировать и распространять Docker-образы между членами команды, серверами и даже целыми организациями.

Возникает логичный вопрос: зачем вообще хранить образы в отдельных репозиториях, если можно просто пересылать файлы? На практике это работает следующим образом: когда мы создаем Docker-образ локально, он остается доступным только на нашей машине. Для развертывания приложения на production-сервере или передачи коллегам потребуется централизованное хранилище — именно здесь в игру вступают репозитории.

Выбор между удаленным, локальным или приватным репозиторием зависит от конкретных задач и требований безопасности:

- Удаленный публичный репозиторий (например, Docker Hub) — оптимальный вариант для open-source проектов и обмена образами с сообществом. Здесь мы размещаем то, что не содержит конфиденциальной информации и может быть доступно широкой аудитории.

- Локальный репозиторий — решение для ситуаций, когда требуется работа в изолированной среде без доступа к интернету, например, в корпоративных сетях с жесткими требованиями к безопасности или при разработке в условиях ограниченной пропускной способности канала.

- Приватный репозиторий — незаменим для коммерческих проектов, где образы содержат проприетарный код, внутренние конфигурации или чувствительные данные компании.

Ключевые преимущества использования Docker-репозиториев формируют целую экосистему эффективной разработки:

- Скорость развертывания: вместо пересборки образа на каждом сервере мы просто загружаем готовую версию из репозитория — процесс занимает минуты, а не часы.

- Безопасность и контроль доступа: приватные репозитории позволяют разграничивать права на чтение и запись образов, что критично для enterprise-разработки.

- Версионирование: каждый образ может иметь множество тегов, что упрощает откат к предыдущим версиям и управление релизами.

- Централизованный обмен: команда получает единый источник истины для всех образов проекта, исключая ситуации «а у меня на машине работает».

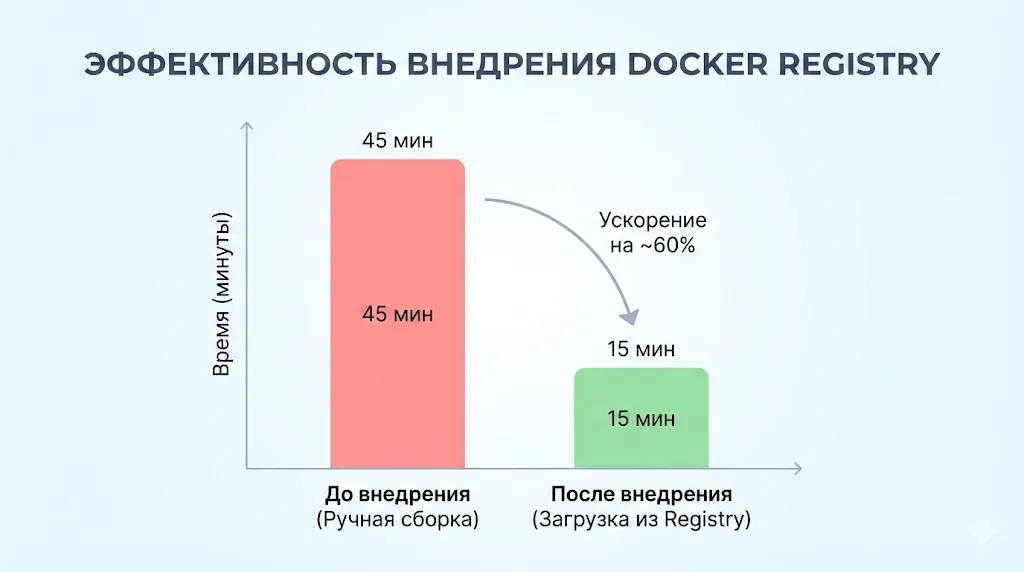

Согласно нашим наблюдениям, организации, внедрившие систему управления репозиториями Docker, отмечают сокращение времени развертывания приложений на 40-60% и значительное снижение числа инцидентов, связанных с несоответствием версий образов между окружениями.

Визуализация показывает, как централизованный репозиторий уменьшает время развертывания за счет загрузки готового образа вместо пересборки на каждом сервере. Такой график усиливает аргумент цифрами и делает вывод понятным «с первого взгляда».

- Варианты Docker-репозиториев: обзор подходов

- Работа с Docker Hub: публикация и скачивание образов

- Как загрузить образ (push)

- Как развернуть локальный Docker-репозиторий

- Настройка приватного репозитория: безопасность и доступ

- Использование Nexus Repository для хранения Docker-образов

- Облачная альтернатива: Container Registry от Selectel

- Команды Docker для работы с репозиториями: шпаргалка

- Заключение

- Рекомендуем посмотреть курсы по обучению DevOps

Варианты Docker-репозиториев: обзор подходов

Экосистема Docker предлагает несколько основных решений для хранения образов, каждое из которых отвечает определенным потребностям разработчиков и организаций. Давайте разберемся, какие варианты существуют на рынке и в каких сценариях каждый из них проявляет себя наилучшим образом.

Docker Hub — публичный репозиторий

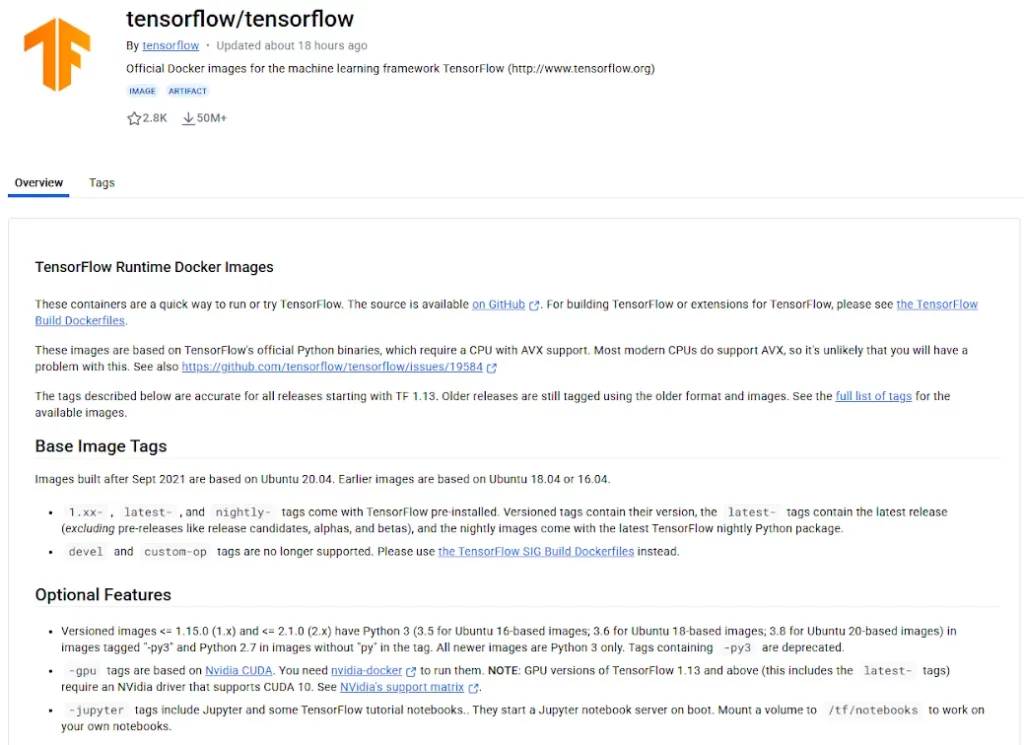

Docker Hub можно считать GitHub’ом для контейнерных образов — это крупнейший публичный репозиторий, который предоставляет бесплатное хранилище для открытых проектов и платные тарифы для приватных образов. Именно отсюда мы загружаем официальные образы Ubuntu, nginx, PostgreSQL и тысячи других популярных приложений.

Главная страница Docker Hub с примерами популярных образов

Преимущества Docker Hub очевидны: глобальная доступность, интеграция с системами CI/CD, автоматическая сборка образов из GitHub-репозиториев. На практике это работает следующим образом: разработчик пушит код в репозиторий, Docker Hub автоматически собирает новый образ и делает его доступным для всей команды. Однако есть и ограничения — бесплатный план включает лимиты на количество скачиваний (rate limits), что может стать проблемой для активно используемых проектов.

Docker Registry — официальный локальный репозиторий Docker

Docker Registry представляет собой open-source решение от создателей Docker, позволяющее развернуть собственное хранилище образов внутри корпоративной сети. В отличие от Docker Hub, это не облачный сервис, а программное обеспечение, которое мы устанавливаем на собственные серверы.

Ключевое преимущество Registry — полный контроль над инфраструктурой: мы сами определяем, где хранятся данные, как настроена безопасность и кто имеет доступ к образам. Это критично для компаний, работающих с чувствительной информацией или в регулируемых отраслях (финансы, здравоохранение), где нормативные требования не позволяют размещать корпоративные данные на внешних платформах.

С технической точки зрения Docker Registry — это легковесное приложение, которое само работает в Docker-контейнере. Минималистичный подход имеет обратную сторону: Registry предоставляет только базовый функционал хранения и раздачи образов, без web-интерфейса, управления пользователями или сканирования уязвимостей из коробки.

Nexus Repository — альтернатива для хранения артефактов

Nexus Repository Manager от компании Sonatype — это универсальное решение для хранения не только Docker-образов, но и других артефактов разработки: Maven-зависимостей, npm-пакетов, Python-библиотек и многого другого. Можно сказать, что Nexus играет роль единого центра управления всеми артефактами в организации.

В отличие от минималистичного Docker Registry, Nexus предлагает полноценный web-интерфейс, гранулярное управление правами доступа, встроенную систему ролей и возможность группировать несколько репозиториев (например, можно создать группу из локального репозитория и прокси к Docker Hub, что позволит кэшировать внешние образы локально).

Возникает вопрос: когда стоит выбирать Nexus вместо простого Registry? Ответ очевиден для организаций, которые уже используют различные технологические стеки и нуждаются в централизованном управлении всеми типами артефактов. Вместо развертывания отдельных хранилищ для Docker, Maven и npm, мы получаем единую платформу с общей системой аутентификации и мониторинга.

Между локальными и удаленными репозиториями существует фундаментальное различие в подходах: локальное решение дает нам максимальный контроль и независимость от внешних сервисов, но требует затрат на поддержку инфраструктуры. Удаленные репозитории, напротив, снимают операционную нагрузку, но создают зависимость от провайдера и могут не соответствовать требованиям безопасности для критичных систем.

Работа с Docker Hub: публикация и скачивание образов

Теперь перейдем к практическим аспектам работы с наиболее популярным публичным репозиторием. Docker Hub остается основным инструментом для большинства разработчиков, поэтому понимание базовых операций публикации и получения образов критически важно для ежедневной работы.

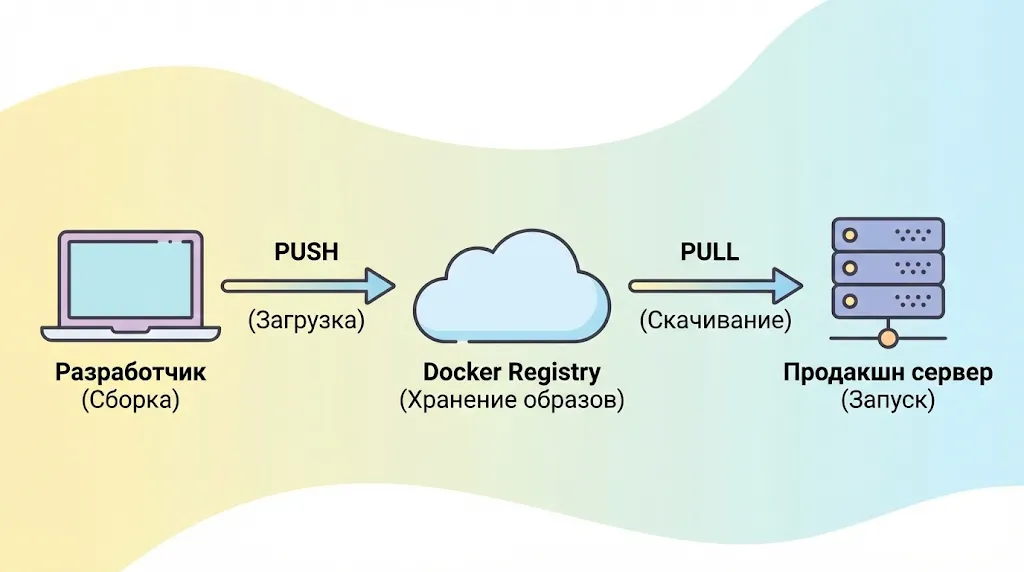

Базовая схема работы с любым Docker-репозиторием. Разработчик отправляет (push) собранный образ в центральное хранилище, откуда целевые серверы скачивают (pull) его для запуска.

Подготовка: вход и авторизация в Docker Hub

Прежде чем начать работу с Docker Hub, необходимо создать учетную запись на платформе. После регистрации на https://hub.docker.com мы получаем доступ к личному пространству, где можем хранить как публичные, так и приватные образы (их количество зависит от выбранного тарифного плана).

Для взаимодействия с Docker Hub через командную строку используется команда авторизации:

docker login --username ваш_логин

После выполнения команды система запросит пароль. Важный момент: учетные данные сохраняются локально в файле ~/.docker/config.json, что позволяет не вводить их повторно при последующих операциях. Однако на shared-серверах или в CI/CD-окружениях рекомендуется использовать токены доступа вместо пароля — это безопаснее и позволяет гранулярно управлять правами.

Как загрузить образ (push)

Загрузка образа в Docker Hub — процесс двухэтапный: сначала мы должны правильно пометить (тегировать) образ, а затем отправить его в репозиторий.

Шаг 1: Тегирование образа. Docker требует, чтобы имя образа соответствовало формату username/repository:tag. Предположим, у нас есть локальный образ myapp, который мы хотим загрузить в Docker Hub:

docker tag myapp ваш_логин/myapp:v1.0

Здесь ваш_логин — имя вашей учетной записи в Docker Hub, myapp — название репозитория, v1.0 — тег версии. Теги играют важную роль в версионировании: можно использовать семантическое (v1.0, v1.1), указывать окружение (prod, staging) или просто использовать стандартный тег latest для последней версии.

Шаг 2: Отправка образа в репозиторий. После корректного тегирования выполняем команду загрузки:

docker push ваш_логин/myapp:v1.0

Docker начнет отправлять слои образа в репозиторий. На практике это работает следующим образом: если какие-то слои уже существуют в Docker Hub (например, базовый образ Ubuntu), они не загружаются повторно — отправляются только уникальные изменения. Это значительно ускоряет процесс и экономит трафик.

Как скачать образ (pull)

Скачивание образов из Docker Hub — операция еще проще. Для публичных образов даже не требуется авторизация:

docker pull ваш_логин/myapp:v1.0

Если тег не указан, Docker автоматически загрузит образ с тегом latest:

docker pull ваш_логин/myapp

Возникает вопрос: что происходит при загрузке? Docker проверяет локальное хранилище на наличие запрашиваемого образа и его слоев. Если он уже существует и его версия совпадает, загрузка не производится. В противном случае скачиваются только недостающие или измененные слои — механизм, который делает работу с Докер исключительно эффективной даже при ограниченной пропускной способности сети.

Для приватных образов перед выполнением pull потребуется авторизация через docker login — без этого Docker Hub вернет ошибку доступа.

Как развернуть локальный Docker-репозиторий

Переходим к практике развертывания собственного хранилища образов. Локальный Docker Registry особенно ценен в корпоративных средах, где требуется полный контроль над инфраструктурой или работа в изолированных сетях без доступа к внешним сервисам.

Установка Docker Registry

Запуск локального репозитория удивительно прост — Registry сам распространяется как Докер-образ, что создает приятную рекурсию: мы используем Docker для управления хранилищем. Базовая команда запуска выглядит следующим образом:

docker run -d -p 5000:5000 --name registry registry:2

Разберем параметры этой команды:

- -d — запуск контейнера в фоновом режиме (detached mode).

- -p 5000:5000 — проброс порта 5000 с контейнера на хост-машину (по умолчанию Registry слушает именно этот порт).

- —name registry — присваиваем контейнеру понятное имя вместо случайного идентификатора.

- registry:2 — официальный образ Docker Registry версии 2.

После выполнения команды наш локальный репозиторий уже работает и готов принимать образы. Однако такая конфигурация имеет существенный недостаток: все данные хранятся внутри контейнера и будут потеряны при его удалении.

Подключение постоянного хранилища

На практике это работает следующим образом: нам необходимо смонтировать внешний том (volume) для сохранения образов на хост-системе. Это обеспечивает персистентность данных и позволяет безопасно перезапускать или обновлять контейнер Registry без потери содержимого.

Усовершенствованная команда запуска с подключением локального хранилища:

docker run -d \ -p 5000:5000 \ --name registry \ -v /mnt/registry:/var/lib/registry \ registry:2

Параметр -v /mnt/registry:/var/lib/registry создает связь между директорией /mnt/registry на хост-машине и /var/lib/registry внутри контейнера — именно там Registry хранит все образы. Теперь даже после удаления контейнера наши образы остаются в безопасности в директории /mnt/registry.

Возникает логичный вопрос: а что если нам нужно изменить порт или другие параметры? Registry поддерживает гибкую конфигурацию через переменные окружения и файлы настроек. Например, можно указать максимальный размер загружаемого образа или настроить политику удаления старых версий — полный список опций доступен в официальной документации Docker.

Проверка работы локального репозитория

Прежде чем начать активно использовать репозиторий, разумно убедиться в его работоспособности. Registry предоставляет простой API для проверки статуса:

curl http://localhost:5000/v2/

Если все настроено корректно, получим ответ:

{}

Пустой JSON-объект — это именно то, что мы ожидаем от свежеустановленного репозитория. Для просмотра списка уже загруженных образов используем:

curl http://localhost:5000/v2/_catalog

Команда вернет список всех репозиториев в JSON-формате. На начальном этапе список будет пустым, но после загрузки первых образов здесь появятся их имена.

Push и pull в локальный Registry

Работа с локальным репозиторием практически идентична взаимодействию с Docker Hub, за исключением адресации — вместо username/image мы используем localhost:5000/image.

Загрузка образа в локальный Registry:

Сначала тегируем существующий образ для локального репозитория:

docker tag myapp localhost:5000/myapp:v1.0

Затем отправляем образ в наш Registry:

docker push localhost:5000/myapp:v1.0

Docker начнет загрузку слоев в локальное хранилище. Процесс обычно выполняется значительно быстрее, чем при работе с Docker Hub, поскольку отсутствуют ограничения внешней сети.

Скачивание образа из локального Registry:

Для получения образа с другой машины в той же сети (предположим, Registry доступен по адресу 192.168.1.100):

docker pull 192.168.1.100:5000/myapp:v1.0

Важный момент: по умолчанию Docker требует защищенного соединения (HTTPS) для работы с репозиториями. Для локального тестирования без настройки SSL необходимо добавить адрес Registry в список доверенных (insecure registries) в конфигурации Docker daemon. Это делается через файл /etc/docker/daemon.json:

{

"insecure-registries": ["192.168.1.100:5000"]

}

После изменения конфигурации требуется перезапуск Docker:

sudo systemctl restart docker

Согласно нашим наблюдениям, такая настройка допустима только для изолированных внутренних сетей — для production-окружений обязательна полноценная настройка HTTPS, о которой мы поговорим в следующем разделе.

Настройка приватного репозитория: безопасность и доступ

Базовая установка Docker Registry решает задачу хранения образов, но для реальных корпоративных сценариев требуется надежная система безопасности. В production-среде недопустимо оставлять репозиторий открытым для любого пользователя сети — необходима аутентификация, авторизация и шифрование трафика. Давайте разберемся, как превратить простое хранилище в защищенный корпоративный Registry.

Настройка SSL-сертификата для Registry

Первый и важнейший шаг обеспечения безопасности — настройка HTTPS. Docker по умолчанию отказывается работать с незащищенными репозиториями (за исключением localhost), и это абсолютно правильная политика, учитывая, что образы могут содержать конфиденциальный код и данные.

Для настройки SSL нам потребуется сертификат. В production-окружении используются сертификаты от доверенных центров (Let’s Encrypt, DigiCert и другие), но для внутренней корпоративной сети можно создать самоподписанный сертификат:

mkdir -p /certs openssl req -newkey rsa:4096 -nodes -sha256 \ -keyout /certs/domain.key -x509 -days 365 \ -out /certs/domain.crt

Команда генерирует приватный ключ (domain.key) и сертификат (domain.crt) сроком действия 365 дней. При выполнении OpenSSL запросит информацию о домене — критически важно указать правильное имя хоста (Common Name), которое будет использоваться для доступа к Registry.

Теперь запускаем Registry с поддержкой HTTPS:

docker run -d \ -p 5000:5000 \ --name registry \ -v /mnt/registry:/var/lib/registry \ -v /certs:/certs \ -e REGISTRY_HTTP_TLS_CERTIFICATE=/certs/domain.crt \ -e REGISTRY_HTTP_TLS_KEY=/certs/domain.key \ registry:2

Обратите внимание на переменные окружения REGISTRY_HTTP_TLS_CERTIFICATE и REGISTRY_HTTP_TLS_KEY — они указывают Registry, где находятся файлы сертификата и ключа.

Важное замечание: при использовании самоподписанных сертификатов на клиентских машинах необходимо добавить сертификат в список доверенных. Для Linux это обычно директория /etc/docker/certs.d/registry-domain:5000/, куда копируется файл ca.crt.

Аутентификация с помощью htpasswd

Шифрование трафика решает проблему перехвата данных, но не ограничивает доступ к репозиторию. Для базовой аутентификации пользователей Docker Registry поддерживает механизм htpasswd — тот же подход, который используется в веб-серверах Apache.

Сначала создаем файл с учетными данными. Для этого потребуется утилита htpasswd из пакета apache2-utils:

mkdir -p /auth htpasswd -Bc /auth/htpasswd username

Команда запросит пароль для пользователя username. Флаг -B использует bcrypt для хеширования пароля (рекомендуемый алгоритм), -c создает новый файл. Для добавления дополнительных пользователей используем команду без флага -c:

htpasswd -B /auth/htpasswd another_user

Возникает вопрос: как интегрировать этот механизм аутентификации в работающий Registry? На практике это работает следующим образом — мы перезапускаем контейнер с дополнительными параметрами:

docker stop registry docker rm registry docker run -d \ -p 5000:5000 \ --name registry \ -v /mnt/registry:/var/lib/registry \ -v /certs:/certs \ -v /auth:/auth \ -e REGISTRY_HTTP_TLS_CERTIFICATE=/certs/domain.crt \ -e REGISTRY_HTTP_TLS_KEY=/certs/domain.key \ -e REGISTRY_AUTH=htpasswd \ -e REGISTRY_AUTH_HTPASSWD_REALM="Registry Realm" \ -e REGISTRY_AUTH_HTPASSWD_PATH=/auth/htpasswd \ registry:2

Ключевые параметры аутентификации:

- REGISTRY_AUTH=htpasswd — выбор механизма аутентификации.

- REGISTRY_AUTH_HTPASSWD_REALM — название области аутентификации (отображается в запросе авторизации).

- REGISTRY_AUTH_HTPASSWD_PATH — путь к файлу с учетными данными.

Авторизация клиентов и работа через docker login

После настройки защищенного Registry клиенты должны авторизоваться перед выполнением операций push или pull. Процесс идентичен работе с Docker Hub:

docker login registry-domain:5000

Docker запросит имя пользователя и пароль, которые мы создали с помощью htpasswd. При успешной авторизации учетные данные сохраняются локально, и последующие операции выполняются автоматически:

docker tag myapp registry-domain:5000/myapp:v1.0 docker push registry-domain:5000/myapp:v1.0

Для автоматизации в CI/CD-пайплайнах можно передавать учетные данные через параметры команды:

echo "password" | docker login registry-domain:5000 -u username --password-stdin

Использование —password-stdin предпочтительнее передачи пароля через параметр -p, поскольку не оставляет следов в истории команд shell.

Важные замечания по безопасности:

- Регулярно ротируйте пароли пользователей и обновляйте файл htpasswd.

- Для enterprise-окружений рассмотрите интеграцию с LDAP или другими корпоративными системами аутентификации.

- SSL-сертификаты имеют срок действия — настройте мониторинг их истечения.

- Логи Registry содержат информацию о всех операциях доступа — используйте их для аудита безопасности.

Согласно нашим наблюдениям, комбинация HTTPS и базовой аутентификации через htpasswd покрывает около 80% сценариев для малых и средних команд. Для более сложных требований (например, role-based access control для разных проектов) стоит рассмотреть альтернативные решения вроде Harbor или Nexus Repository, которые предлагают расширенные возможности управления доступом.

Использование Nexus Repository для хранения Docker-образов

Nexus Repository Manager представляет собой более мощную альтернативу базовому Docker Registry, особенно когда в организации используется множество различных технологий и артефактов. В отличие от специализированного Registry, Nexus — это универсальная платформа, способная одновременно хранить Docker-образы, Maven-зависимости, npm-пакеты, Python-библиотеки и десятки других типов артефактов. Можно сказать, что Nexus играет роль единого хаба для всей экосистемы разработки.

Развёртывание Nexus Repository

Nexus доступен в двух редакциях: OSS (open-source) и Pro (коммерческая версия с расширенными возможностями). Для большинства задач хранения Docker-образов достаточно бесплатной OSS-версии. Наиболее удобный способ развертывания — использование Docker Compose, что создает приятную иронию: мы разворачиваем систему управления Docker-образами с помощью самого Docker.

Создаем файл docker-compose.yml:

version: '3' services: nexus: image: sonatype/nexus3:latest container_name: nexus ports: - "8081:8081" - "8082:8082" volumes: - nexus-data:/nexus-data environment: - INSTALL4J_ADD_VM_PARAMS=-Xms2g -Xmx2g volumes: nexus-data:

Разберем ключевые параметры конфигурации:

- Порт 8081 — web-интерфейс управления Nexus.

- Порт 8082 — будет использоваться для Docker-репозитория (можно настроить любой).

- Volume nexus-data — постоянное хранилище всех данных Nexus.

- Параметры JVM памяти — Nexus требует минимум 2GB RAM для стабильной работы.

Запускаем Nexus:

docker-compose up -d

Первый запуск может занять несколько минут — Nexus инициализирует базу данных и создает необходимые структуры. После запуска интерфейс доступен по адресу http://localhost:8081. При первом входе потребуется пароль администратора, который генерируется автоматически и хранится в файле /nexus-data/admin.password внутри контейнера:

docker exec nexus cat /nexus-data/admin.password

Создание Docker-репозитория через интерфейс Nexus

После авторизации в web-интерфейсе переходим к настройке Docker-репозитория. Nexus предлагает три типа, каждый из которых решает определенные задачи:

- Hosted — наш собственный для хранения образов (аналог локального Registry)

- Proxy — кэширующий прокси для внешних репозиториев, например Docker Hub

- Group — виртуальный репозиторий, объединяющий несколько hosted и proxy.

На практике это работает следующим образом: разработчики используют единую точку доступа (group), которая сначала проверяет локальные образы (hosted), а при их отсутствии обращается к внешним репозиториям через прокси, автоматически кэшируя результаты.

Создание Hosted-репозитория:

- В интерфейсе Nexus: Settings → Repository → Repositories → Create repository

- Выбираем тип docker (hosted)

- Указываем параметры:

- Name: docker-hosted

- HTTP connector: 8082 (порт для Docker API).

- Enable Docker V1 API: отключено (устаревший протокол)

- Deployment policy: Allow redeploy или Disable redeploy в зависимости от политики версионирования

Создание Proxy-репозитория для Docker Hub:

- Create repository → docker (proxy)

- Параметры:

- Name: docker-proxy

- Remote storage: https://registry-1.docker.io

- Docker Index: Use Docker Hub

- HTTP connector: отдельный порт не требуется для proxy

Создание Group-репозитория:

- Create repository → docker (group)

- Параметры:

- Name: docker-group

- HTTP connector: 8083

- Member repositories: добавляем docker-hosted и docker-proxy

Возникает вопрос: зачем такая сложная структура из трех репозиториев? Ответ кроется в оптимизации работы команды — group-репозиторий обеспечивает единую точку доступа, прокси кэширует внешние образы (экономя трафик и ускоряя загрузку), а hosted хранит внутренние образы компании.

Настройка безопасности и пользователей

Nexus предлагает значительно более гибкую систему управления доступом по сравнению с базовым htpasswd в Docker Registry. Можно создавать роли с точными правами, назначать их пользователям и даже интегрироваться с LDAP/Active Directory.

Создание пользователя:

- Settings → Security → Users → Create local user

- Заполняем данные:

- ID: developer

- Password: устанавливаем надежный пароль

- Status: Active

- Roles: назначаем роль nx-admin для полного доступа или создаем кастомную роль

Создание кастомной роли для Docker:

- Settings → Security → Roles → Create role

- Параметры:

- Role ID: docker-developer

- Role name: Docker Developer

- Privileges: добавляем nx-repository-view-docker-*-* для чтения и nx-repository-view-docker-*-add для публикации

Настройка SSL для Docker-репозитория:

Для production-использования необходимо настроить HTTPS. Nexus поддерживает два подхода:

- Прямое подключение SSL — настройка сертификата в самом Nexus (требует редактирования конфигурации JVM).

- Reverse proxy — размещение Nginx или Apache перед Nexus (рекомендуемый подход).

Пример конфигурации Nginx для проксирования Docker-репозитория:

server {

listen 443 ssl;

server_name docker.company.com;

ssl_certificate /etc/nginx/ssl/cert.pem;

ssl_certificate_key /etc/nginx/ssl/key.pem;

location / {

proxy_pass http://localhost:8082;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto "https";

}

}

Работа с образами: push и pull

После настройки Nexus работа с образами практически идентична Docker Hub или Registry, с небольшими нюансами в адресации.

Авторизация в Nexus:

docker login docker.company.com:8082 -u developer

Публикация образа в hosted-репозиторий:

docker tag myapp docker.company.com:8082/myapp:v1.0 docker push docker.company.com:8082/myapp:v1.0

Получение образа через group-репозиторий:

Используем group-репозиторий (порт 8083), который автоматически определит источник образа:

docker pull docker.company.com:8083/myapp:v1.0 docker pull docker.company.com:8083/nginx:latest

В первом случае Nexus вернет образ из hosted-репозитория, во втором — загрузит nginx из Docker Hub через прокси и закэширует локально. При повторных запросах тот же nginx будет отдаваться из кэша, что значительно ускоряет развертывание и снижает зависимость от внешних сервисов.

Согласно нашим наблюдениям, внедрение Nexus Repository в средних и крупных командах приводит к сокращению времени сборки CI/CD-пайплайнов на 30-50% за счет кэширования внешних зависимостей и централизованного управления артефактами. Однако за эти преимущества приходится платить дополнительной сложностью инфраструктуры и требованиями к ресурсам — Nexus потребляет существенно больше памяти и процессорного времени по сравнению с минималистичным Docker Registry.

Облачная альтернатива: Container Registry от Selectel

Развертывание и поддержка собственной инфраструктуры репозиториев — задача, требующая компетенций, времени и ресурсов. Возникает закономерный вопрос: а что если делегировать операционную нагрузку облачному провайдеру, сохранив при этом контроль над образами и безопасность данных? Именно для таких сценариев создаются управляемые облачные решения вроде Container Registry от Selectel.

Container Registry представляет собой полностью управляемый сервис для хранения Docker-образов, который избавляет команды от необходимости администрировать серверы, настраивать репликацию и мониторить дисковое пространство. Можно сказать, что это играет роль «Docker Registry as a Service» — мы получаем все преимущества приватного репозитория без операционных затрат на его поддержку.

Ключевые преимущества облачного подхода:

- Автоматическая репликация данных — образы хранятся в нескольких дата-центрах одновременно, что обеспечивает отказоустойчивость и защиту от потери данных. Если один из дата-центров становится недоступен, сервис продолжает работать без прерывания, автоматически переключаясь на резервные копии.

- Высокая скорость доступа — географически распределенная инфраструктура позволяет загружать образы с минимальными задержками. На практике это работает так: при запросе образа система автоматически выбирает ближайший к пользователю сервер, что особенно критично для команд с распределенной географией.

- Простота интеграции — полноценный API и поддержка инструментов Infrastructure as Code (Terraform, Ansible) позволяют автоматизировать управление репозиториями. Вместо ручной настройки через web-интерфейс мы описываем желаемое состояние инфраструктуры в коде, что упрощает репликацию окружений и соответствует best practices DevOps-культуры.

- Отсутствие операционной нагрузки — не нужно беспокоиться об обновлениях, резервном копировании, мониторинге дискового пространства или настройке SSL-сертификатов. Провайдер берет на себя всю операционную ответственность, оставляя команде возможность сосредоточиться на разработке продукта.

- Гибкое управление доступом — встроенная система ролей и токенов позволяет точно контролировать, кто и какие операции может выполнять с образами. Для CI/CD-пайплайнов создаются сервисные токены с ограниченными правами, что соответствует принципу минимальных привилегий.

- Прозрачная тарификация — оплата только за фактически используемый объем хранилища и трафик, без необходимости заранее резервировать серверные мощности.

Сравнивая с локальными решениями, облачный Container Registry выигрывает в простоте запуска и отсутствии необходимости поддерживать инфраструктуру, но создает зависимость от внешнего провайдера. Для организаций с жесткими требованиями к размещению данных (например, банки или государственные структуры) локальные решения остаются предпочтительными. Однако для большинства коммерческих проектов, особенно стартапов и средних команд, облачный подход обеспечивает оптимальный баланс между функциональностью, безопасностью и операционными затратами.

Облачные решения (Managed Registry) снимают с команды задачи по администрированию инфраструктуры, позволяя сосредоточиться на разработке.

Согласно нашим наблюдениям, переход с самостоятельно поддерживаемого Registry на управляемый облачный сервис высвобождает до 15-20 часов DevOps-времени ежемесячно — ресурс, который можно направить на развитие продукта вместо администрирования инфраструктуры.

Команды Docker для работы с репозиториями: шпаргалка

Для удобства мы собрали все ключевые команды для работы с Docker-репозиториями в единую справочную таблицу. Этот раздел можно использовать как quick reference при ежедневной работе с образами.

| Команда | Назначение |

|---|---|

| docker login | Авторизация в Docker Hub |

| docker login registry.example.com | Авторизация в приватном репозитории |

| docker tag image:tag user/image:tag | Тегирование образа для публикации |

| docker push user/image:tag | Загрузка образа в репозиторий |

| docker pull user/image:tag | Скачивание образа из репозитория |

| docker logout | Выход из учетной записи репозитория |

| docker run -d -p 5000:5000 —name registry registry:2 | Запуск локального Docker Registry |

| docker run -d -p 5000:5000 -v /data:/var/lib/registry registry:2 | Запуск Registry с постоянным хранилищем |

| curl http://localhost:5000/v2/_catalog | Просмотр списка образов в Registry |

| docker tag myapp localhost:5000/myapp | Тегирование для локального репозитория |

| docker push localhost:5000/myapp | Загрузка в локальный Registry |

Часто используемые команды для быстрого копирования:

# Авторизация и публикация в Docker Hub docker login --username your_username docker tag myapp your_username/myapp:v1.0 docker push your_username/myapp:v1.0 # Работа с локальным Registry docker run -d -p 5000:5000 -v /mnt/registry:/var/lib/registry --name registry registry:2 docker tag myapp localhost:5000/myapp:latest docker push localhost:5000/myapp:latest # Работа с приватным репозиторием docker login registry.company.com docker tag myapp registry.company.com/project/myapp:v1.0 docker push registry.company.com/project/myapp:v1.0 docker pull registry.company.com/project/myapp:v1.0 # Проверка Registry curl http://localhost:5000/v2/ curl http://localhost:5000/v2/_catalog

Возникает вопрос: как запомнить все эти команды и их параметры? На практике большинство разработчиков используют aliases в shell или интегрируют команды в CI/CD-скрипты, что избавляет от необходимости каждый раз вводить полные команды вручную. Современные IDE также предлагают плагины для работы с Docker, которые автоматизируют рутинные операции с репозиториями.

Заключение

Теперь мы владеем полным арсеналом инструментов для работы с Docker-репозиториями — от базовых операций публикации образов в Docker Hub до развертывания защищенных корпоративных хранилищ с тонкой настройкой доступа. Подведем итоги:

- Докер нужен для распространения и использования контейнеров. Он избавляет команду от ручной передачи образов и проблем с несовпадением версий.

- Публичные, локальные и приватные репозитории решают разные задачи. Выбор зависит от требований к безопасности, доступности и операционной нагрузке.

- Docker Hub подходит для open-source и быстрого старта. Он удобен, но имеет ограничения по доступу и загрузкам.

- Локальный Docker Registry дает полный контроль над данными. Это оптимальное решение для изолированных сетей и корпоративных инфраструктур.

- Nexus Repository расширяет возможности работы с образами. Он позволяет централизованно управлять Docker-образами и другими артефактами в одной системе.

- Облачные container registry снижают нагрузку на DevOps-команды. Они позволяют сосредоточиться на развитии продукта, а не поддержке инфраструктуры.

Если вы рекомендуем обратить внимание на подборку курсов по Devops, особенно если вы только начинаете осваивать профессию DevOps-инженера. В этих курсах есть теоретическая и практическая часть, что помогает быстрее разобраться с репозиториями, образами и реальными сценариями работы.

Рекомендуем посмотреть курсы по обучению DevOps

| Курс | Школа | Цена | Рассрочка | Длительность | Дата начала | Ссылка на курс |

|---|---|---|---|---|---|---|

|

DevOps-инженер

|

Eduson Academy

100 отзывов

|

Цена

Ещё -5% по промокоду

115 000 ₽

|

От

9 583 ₽/мес

0% на 24 месяца

14 880 ₽/мес

|

Длительность

8 месяцев

|

Старт

18 января

Пн, Ср, 19:00-22:00 по МСК

|

Ссылка на курсПодробнее |

|

Девопс-инженер. Интенсив

|

Level UP

36 отзывов

|

Цена

78 990 ₽

|

От

26 330 ₽/мес

|

Длительность

4 месяца

|

Старт

20 января

|

Ссылка на курсПодробнее |

|

DevOps-инженер

|

Нетология

45 отзывов

|

Цена

с промокодом kursy-online

84 800 ₽

178 600 ₽

|

От

3 720 ₽/мес

Без переплат на 2 года.

4 861 ₽/мес

|

Длительность

16 месяцев

|

Старт

15 февраля

|

Ссылка на курсПодробнее |

|

Профессия DevOps-инженер

|

Skillbox

215 отзывов

|

Цена

Ещё -20% по промокоду

161 751 ₽

323 502 ₽

|

От

4 757 ₽/мес

Без переплат на 22 месяца с отсрочкой платежа 3 месяца.

|

Длительность

4 месяца

|

Старт

18 января

|

Ссылка на курсПодробнее |

|

DevOps для эксплуатации и разработки

|

Яндекс Практикум

98 отзывов

|

Цена

160 000 ₽

|

От

23 000 ₽/мес

|

Длительность

6 месяцев

Можно взять академический отпуск

|

Старт

9 февраля

|

Ссылка на курсПодробнее |

Лучшие книги по тестированию программного обеспечения в 2025 году

Не знаете, с каких книг начать путь в тестировании? Подобрали лучшие издания: от базовых руководств до продвинутых книг по TDD, SQL и управлению QA.

Стратегия автоматизации тестирования: этапы успеха

Хотите, чтобы автоматизация тестирования приносила реальную пользу, а не становилась тратой времени? Расскажем о каждом этапе стратегии и поделимся

Как управлять вниманием зрителя с помощью композиции

Визуальный хаос или идеально сбалансированный дизайн? Разница кроется в композиции! Узнайте, как грамотно выстраивать структуру изображения, чтобы ваш контент работал на результат.

Библиотека Retrofit для Android: обзор и примеры использования

Что даёт Retrofit Android-разработчику и почему его считают стандартом работы с API? В статье вы найдёте ответы, примеры и советы, которые помогут быстрее освоить инструмент.