Стек ELK (Elasticsearch, Logstash и Kibana) — что это такое?

В мире современной разработки логи — это не просто технические записи, а настоящий компас, который помогает навигировать в сложных системах. Однако слишком часто мы наблюдаем картину, когда после развертывания приложения о журналах событий попросту забывают — до первого серьезного инцидента.

ELK-стек (Elasticsearch, Logstash, Kibana) представляет собой мощное решение для централизованного логирования, которое превращает хаотичные потоки данных в структурированную систему мониторинга. Этот набор open-source инструментов, дополненный агентом Filebeat, позволяет не просто собирать логи с множества серверов, но и анализировать их в режиме реального времени.

Основные возможности стека включают:

- Централизованный сбор и хранение логов из любых источников.

- Мощный полнотекстовый поиск с поддержкой сложных запросов.

- Гибкую обработку и трансформацию данных на лету.

- Создание интерактивных дашбордов и визуализаций.

- Настройку алертов и уведомлений о критических событиях.

- Масштабирование под любые объемы данных.

Давайте разберемся, как эти инструменты помогают решать ключевые задачи DevOps-команд и почему стек стал стандартом де-факто в области управления логами.

- Что такое ELK-стек

- Компоненты ELK-стека

- Почему ELK-стек популярен

- Преимущества ELK-стека

- Недостатки ELK-стека

- Установка и настройка ELK-стека

- Практическое применение ELK

- Заключение

- Рекомендуем посмотреть курсы по системной аналитике

Что такое ELK-стек

ELK-стек — это программный комплекс, объединяющий три ключевых компонента: Elasticsearch, Logstash и Kibana. Название представляет собой аббревиатуру от первых букв этих open-source проектов, разрабатываемых и поддерживаемых компанией Elastic. В профессиональной среде стек также называют «эластичным» — небольшая игра слов, отсылающая к названию компании-разработчика.

Изначально каждый компонент решал свою узкую задачу: Elasticsearch выступал как поисковый движок, Logstash обрабатывал данные, а Kibana предоставлял интерфейс визуализации. Однако со временем синергия между этими инструментами превратила их в единую экосистему для работы с большими объемами структурированных и неструктурированных данных.

Стек находит применение в широком спектре сценариев:

- DevOps и эксплуатация: мониторинг инфраструктуры, отслеживание производительности приложений.

- Разработка: поиск и анализ ошибок, отладка распределенных систем.

- Информационная безопасность: анализ логов безопасности, выявление аномалий.

- Бизнес-аналитика: обработка пользовательских данных, анализ поведения клиентов.

Ключевое преимущество ELK заключается в способности работать с данными в режиме Near Real Time (NRT) — это означает, что от момента поступления лога до его индексации и доступности для поиска проходят считанные секунды. Такая оперативность критически важна для быстрого реагирования на инциденты и принятия обоснованных решений на основе актуальных данных.

Компоненты ELK-стека

Elasticsearch

Elasticsearch выступает сердцем всего стека — это распределенная RESTful-система на основе JSON, которая сочетает функции NoSQL-базы данных, поисковой системы и аналитической платформы. Изначально разработанный как надстройка над поисковой библиотекой Apache Lucene, Elasticsearch быстро эволюционировал в самостоятельное решение для работы с большими данными.

Главная страница Elasticsearch.

Основные особенности включают:

- Горизонтальное масштабирование: автоматическое распределение данных по узлам кластера.

- Полнотекстовый поиск: мощные возможности поиска с поддержкой различных языков.

- Схемы без жесткой структуры: гибкость в работе с JSON-документами.

- Отказоустойчивость: автоматическая репликация и восстановление данных.

В контексте логирования Elasticsearch решает задачи быстрого индексирования поступающих событий и выполнения сложных поисковых запросов — от простого поиска по ключевым словам до комплексной аналитики с агрегацией данных.

Logstash

Logstash представляет собой конвейер обработки данных, который принимает логи из множественных источников, трансформирует их и направляет в Elasticsearch. Этот компонент работает по принципу ETL (Extract, Transform, Load) и поддерживает более 200 плагинов для интеграции с различными системами.

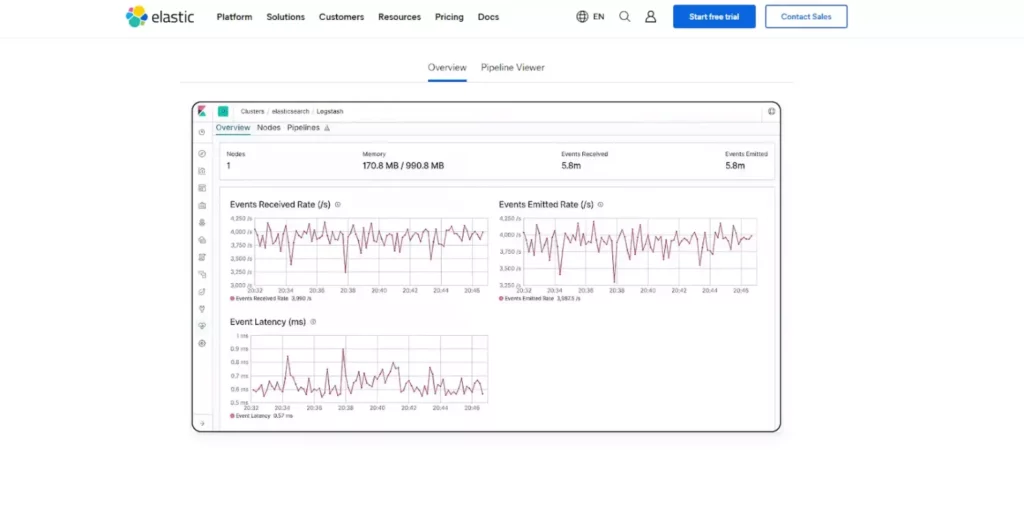

Главная страница Logstash.

Архитектура Logstash строится вокруг трех основных этапов:

- Input: получение данных из файлов, сетевых подключений, баз данных.

- Filter: парсинг, обогащение и трансформация логов с помощью регулярных выражений и готовых шаблонов.

- Output: отправка обработанных данных в Elasticsearch или другие системы хранения.

Особую ценность представляет встроенный парсер Grok, который позволяет извлекать структурированные данные из неструктурированных логов с помощью предопределенных шаблонов.

Kibana

Kibana служит веб-интерфейсом для взаимодействия с данными, хранящимися в Elasticsearch. Этот компонент превращает сырые логи в понятные графики, диаграммы и интерактивные дашборды.

Главная страница Kibana.

Ключевые возможности включают:

- Визуализация данных: создание графиков, тепловых карт, геокарт.

- Дашборды: объединение множественных визуализаций в единые панели мониторинга.

- Поисковые возможности: от простого текстового поиска до сложных запросов с логическими операторами.

- Административные функции: управление индексами, пользователями и настройками кластера.

Filebeat

Filebeat дополняет основную триаду как легковесный агент для сбора и доставки логов. В отличие от ресурсоемкого Logstash, Filebeat потребляет минимум системных ресурсов, что делает его идеальным для установки на продакшн-серверы.

Агент обеспечивает:

- Надежную доставку: гарантирует передачу логов даже при временных сбоях сети.

- Мониторинг файлов: отслеживание изменений в лог-файлах в реальном времени.

- Буферизацию: временное хранение данных при недоступности получателя.

Связка Filebeat + Logstash + Elasticsearch формирует надежный pipeline для сбора, обработки и хранения логов любого масштаба.

Почему ELK-стек популярен

В эпоху данных, когда объемы информации растут экспоненциально, традиционные подходы к анализу журналов становятся неэффективными. Мы живем в мире, где системы должны обрабатывать терабайты логов ежедневно, а время реакции на инциденты измеряется минутами, а не часами.

ELK-стек завоевал популярность благодаря решению фундаментальной проблемы: как превратить хаос разрозненных логов в упорядоченную систему мониторинга? Ответ кроется в уникальном сочетании открытого исходного кода, гибкости архитектуры и способности масштабироваться от стартапа до enterprise-уровня.

Ключевые факторы популярности включают:

Open-source природа — отсутствие лицензионных ограничений позволяет компаниям любого размера внедрять решение без значительных первоначальных инвестиций. При этом вокруг стека сформировалось активное сообщество, которое постоянно развивает экосистему плагинов и интеграций.

Горизонтальное масштабирование — архитектура позволяет начать с единственного сервера и постепенно расширяться до кластеров из сотен узлов. Такая гибкость особенно ценна для растущих компаний.

Работа в режиме реального времени — возможность получать insights из данных практически мгновенно революционизировала подходы к мониторингу. Инженеры могут обнаруживать и устранять проблемы до того, как они повлияют на пользователей.

Преимущества ELK-стека

Внедрение ELK-стека приносит ощутимые преимущества, которые выходят далеко за рамки простого сбора логов. Давайте рассмотрим ключевые достоинства, которые делают этот инструментарий незаменимым в современной IT-инфраструктуре.

Централизованное управление логами

ELK позволяет объединить разрозненные потоки данных с десятков или сотен серверов в единое хранилище. Это решает проблему, знакомую каждому системному администратору: необходимость подключаться к множеству серверов для поиска причин инцидента. Теперь все логи доступны из единой точки входа.

Мощные поисковые возможности

Elasticsearch предоставляет возможности полнотекстового поиска, которые превосходят традиционные инструменты типа grep. Поддержка сложных запросов с логическими операторами, фильтрация по временным интервалам и агрегация данных позволяют быстро находить нужную информацию в терабайтах логов.

Интуитивная визуализация

Kibana превращает сухие строки логов в наглядные графики и дашборды. Возможность создавать интерактивные визуализации помогает выявлять тренды, аномалии и закономерности, которые сложно заметить при анализе текстовых файлов.

Богатая экосистема интеграций

Стек поддерживает более 200 плагинов для подключения к различным источникам данных — от веб-серверов и баз данных до облачных сервисов и IoT-устройств. Это обеспечивает гибкость в выборе технологического стека.

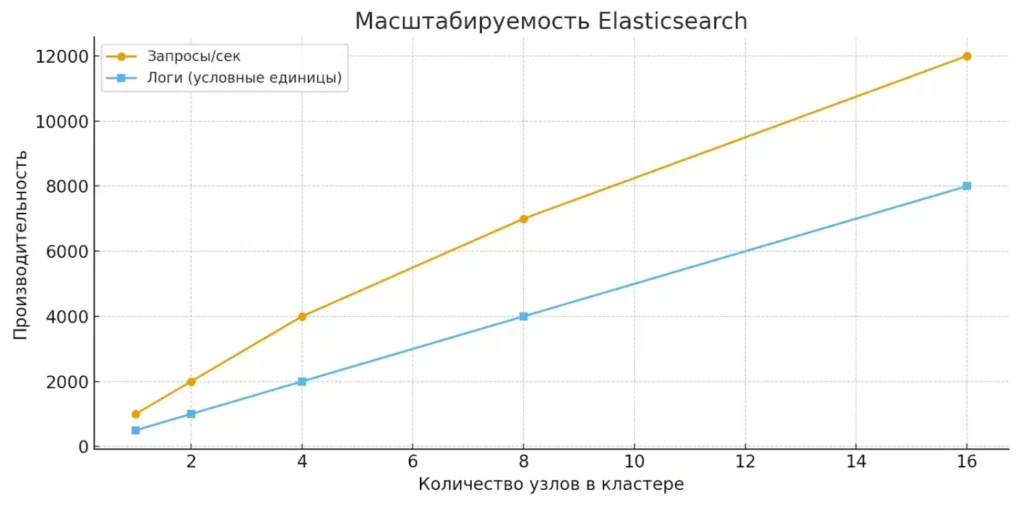

Высокая производительность и масштабируемость

Распределенная архитектура Elasticsearch автоматически распределяет нагрузку между узлами кластера, обеспечивая линейное масштабирование производительности при добавлении новых серверов.

Диаграмма показывает, как рост числа узлов в кластере увеличивает производительность системы.

Отказоустойчивость

Встроенные механизмы репликации гарантируют сохранность данных даже при выходе из строя отдельных узлов кластера. Данные автоматически перебалансируются между оставшимися серверами.

Гибкость конфигурации

Возможность тонкой настройки каждого компонента под специфические требования проекта — от настройки парсеров логов до создания кастомных аналитических алгоритмов.

Недостатки ELK-стека

Несмотря на внушительный список преимуществ, ELK-стек не лишен ограничений, о которых важно знать перед внедрением. Понимание этих аспектов поможет принять взвешенное решение и заранее подготовиться к возможным вызовам.

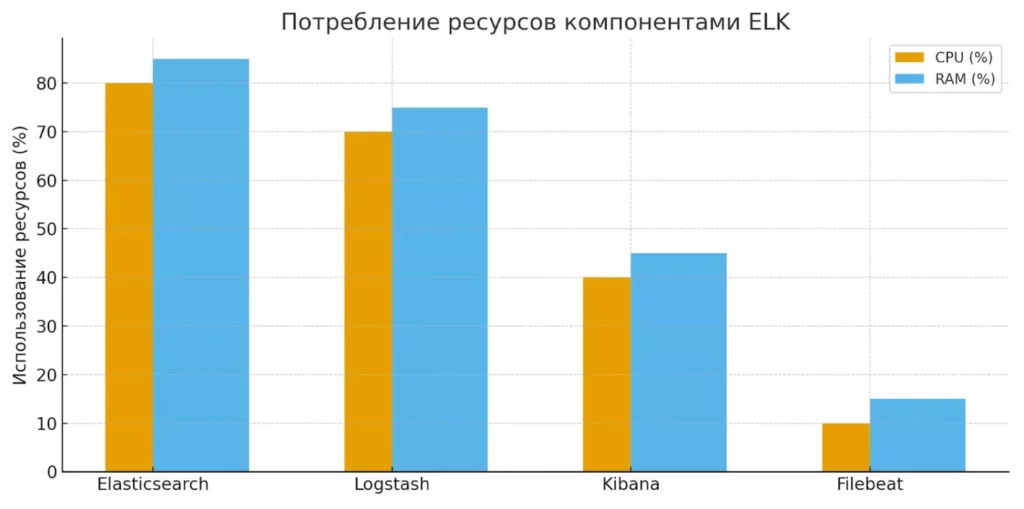

Столбчатая диаграмма демонстрирует использование CPU и RAM различными компонентами стека. Elasticsearch и Logstash наиболее требовательны к ресурсам, в отличие от лёгкого агента Filebeat.

| Проблема | Описание | Рекомендации |

|---|---|---|

| Сложность установки и настройки | Развертывание полноценного стека требует глубоких знаний каждого компонента и понимания их взаимодействия | Начинать с облачных решений или использовать Docker-контейнеры для упрощения |

| Высокие требования к ресурсам | JVM-основа Elasticsearch и Logstash потребляет значительные объемы CPU и RAM, особенно при высоких нагрузках | Тщательное планирование ресурсов, мониторинг производительности JVM |

| Отсутствие встроенной безопасности | Базовая установка не включает авторизацию и шифрование, что создает риски для информационной безопасности | Обязательная настройка X-Pack Security или использование внешних решений |

| Сложность Query DSL | Elasticsearch использует специфический язык запросов, освоение которого требует времени | Использование Kibana Query Language (KQL) как более простой альтернативы |

| Риск потери данных | При превышении лимитов хранилища узла индексация может давать сбои | Настройка политик управления жизненным циклом индексов (ILM) |

Экономические аспекты

Масштабирование ELK может оказаться затратным — особенно это касается лицензионных функций X-Pack и облачного сервиса Elastic Cloud. Для крупных объемов данных стоимость инфраструктуры растет существенно.

Операционная сложность

Поддержание стабильной работы кластера требует постоянного мониторинга метрик производительности, управления индексами и планирования capacity. Для организаций без собственной экспертизы это может потребовать найма специализированных инженеров или инвестиций в обучение команды.

Версионная совместимость

Обновления компонентов стека требуют тщательного планирования — не все версии Elasticsearch, Logstash и Kibana совместимы между собой. Rolling upgrade в продакшене может быть сложной операцией.

Важно отметить, что большинство этих недостатков решаемы при правильном подходе к архитектуре и эксплуатации системы. Ключ к успеху — реалистичная оценка своих возможностей и поэтапное внедрение с постепенным наращиванием сложности.

Установка и настройка ELK-стека

Развертывание ELK-стека — процесс, требующий системного подхода и понимания архитектурных особенностей каждого компонента. Рассмотрим основные этапы установки и ключевые моменты конфигурации.

Подходы к установке

Существует несколько стратегий развертывания ELK, каждая из которых имеет свои преимущества:

Локальная установка — классический подход с использованием пакетных менеджеров операционной системы. Обеспечивает максимальный контроль над конфигурацией, но требует глубоких знаний администрирования.

Docker-контейнеризация — современный способ, упрощающий развертывание и обеспечивающий изоляцию компонентов. Elastic предоставляет официальные образы для всех компонентов стека.

Облачные решения — Elastic Cloud или развертывание в AWS/GCP/Azure с использованием готовых шаблонов. Минимизирует операционные сложности, но увеличивает стоимость владения.

Управление конфигурацией — использование Ansible, Puppet или Terraform для автоматизации развертывания в больших средах.

Предварительные требования

Для комфортной работы одиночного инстанса ELK рекомендуются следующие системные ресурсы:

- CPU: минимум 4 ядра, рекомендуется 8+.

- RAM: 16GB для тестирования, 32GB+ для продакшена.

- Дисковое пространство: SSD с минимум 50GB свободного места.

- Java: обязательна установка OpenJDK 11 или Oracle JDK 11.

Критически важно обеспечить сетевую безопасность — по умолчанию Elasticsearch открывает порт 9200 без аутентификации, что создает серьезные риски. Обязательно настройте файрвол и рассмотрите использование VPN или закрытых сетей для доступа к кластеру.

Установка компонентов

- Filebeat (агент сбора логов)

# CentOS/RHEL curl -L -O https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-8.x.x-x86_64.rpm rpm -vi filebeat-8.x.x-x86_64.rpm # Ubuntu/Debian wget -qO - https://artifacts.elastic.co/GPG-KEY-elasticsearch | sudo apt-key add - apt install filebeat

Конфигурация в /etc/filebeat/filebeat.yml определяет источники логов и получателей данных.

- Elasticsearch (ядро системы)

# Добавление репозитория Elastic rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch yum install elasticsearch # Базовая настройка в /etc/elasticsearch/elasticsearch.yml path.data: /var/lib/elasticsearch network.host: 127.0.0.1 discovery.seed_hosts: ["127.0.0.1"] cluster.initial_master_nodes: ["node-1"]

- Kibana (интерфейс визуализации)

yum install kibana # Настройка в /etc/kibana/kibana.yml server.host: "0.0.0.0" elasticsearch.hosts: ["http://localhost:9200"]

- Logstash (обработка данных)

yum install logstash # Конфигурация pipeline в /etc/logstash/conf.d/

Пример простого pipeline для обработки nginx-логов:

input {

beats {

port => 5044

}

}

filter {

if [fields][logtype] == "nginx" {

grok {

match => { "message" => "%{NGINXACCESS}" }

}

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "nginx-%{+YYYY.MM.dd}"

}

}

Последовательность запуска сервисов критична: сначала Elasticsearch, затем Kibana, после — Logstash, и в завершение — агенты Filebeat. Каждый компонент должен полностью инициализироваться перед запуском следующего в цепочке.

Практическое применение ELK

ELK-стек находит применение в широком спектре сценариев — от базового мониторинга веб-приложений до сложных систем анализа безопасности. Рассмотрим ключевые области использования и практические кейсы, которые демонстрируют реальную ценность инструмента.

Мониторинг приложений и инфраструктуры

В современных микросервисных архитектурах одно пользовательское действие может инициировать цепочку вызовов через десятки сервисов. ELK позволяет отслеживать весь путь запроса, выявлять узкие места производительности и быстро локализовать источники ошибок. Correlation ID в логах помогает связать события из разных компонентов в единую картину.

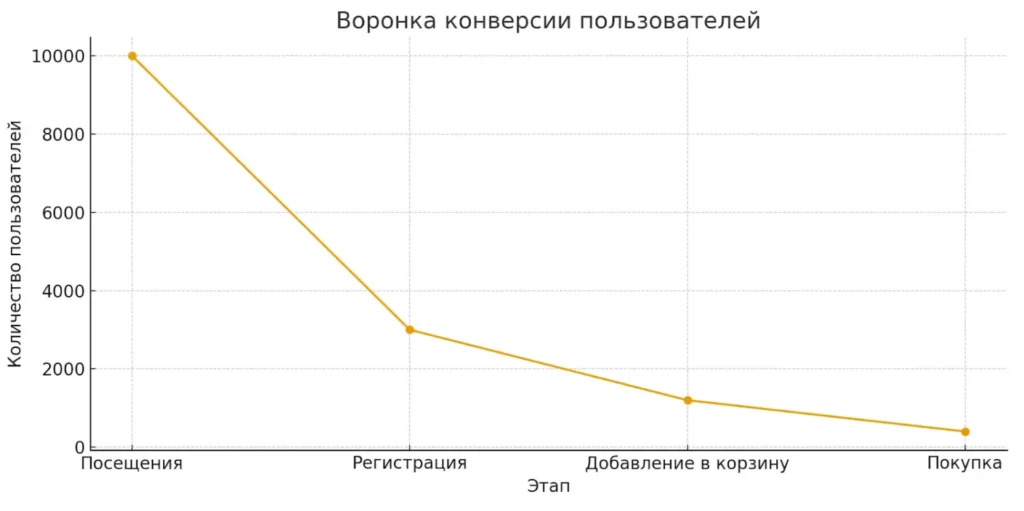

Практический пример: e-commerce платформа использует ELK для мониторинга времени отклика API, анализа конверсии на разных этапах воронки продаж и отслеживания аномалий в поведении пользователей.

Поиск и устранение инцидентов

Когда происходит production-инцидент, время реакции критично. ELK предоставляет инженерам возможность мгновенно находить релевантные логи по timestamp, trace ID или ключевым словам. Kibana-дашборды с real-time метриками помогают оценить масштаб проблемы и отслеживать эффективность принимаемых мер.

Типичный workflow включает: обнаружение аномалии через алерты → поиск в Kibana по временному интервалу → анализ error-логов → корреляция с метриками инфраструктуры → локализация root cause.

Анализ безопасности и соответствие требованиям

Security teams используют ELK для агрегации логов с файрволов, intrusion detection систем, веб-серверов и приложений. Машинное обучение в Elasticsearch помогает выявлять аномальные паттерны доступа, потенциальные атаки и нарушения политик безопасности.

Для compliance с регуляторными требованиями (SOX, GDPR, PCI DSS) ELK обеспечивает централизованное хранение audit-логов с возможностью быстрого поиска и генерации отчетов.

DevOps и CI/CD интеграция

В DevOps-процессах ELK интегрируется с системами непрерывной интеграции для анализа логов билдов, deployment’ов и автоматизированных тестов. Это позволяет быстро выявлять регрессии, отслеживать качество релизов и автоматизировать rollback при обнаружении критических ошибок.

Бизнес-аналитика и продуктовые метрики

Помимо технических логов, ELK эффективно обрабатывает пользовательские события — клики, просмотры, покупки. Kibana-дашборды предоставляют product-менеджерам и аналитикам real-time insights о поведении пользователей, эффективности A/B-тестов и конверсии фичей.

График иллюстрирует, как ELK помогает анализировать пользовательский путь: от посещения до покупки. Такой анализ позволяет выявлять узкие места и улучшать продукт.

Кейс SaaS-платформы: компания использует ELK для анализа feature adoption, выявления проблемных участков user journey и оптимизации onboarding-процесса. Логи API-вызовов помогают понять, какие функции действительно используются клиентами.

Ключевое преимущество ELK в том, что он объединяет техническую и бизнес-аналитику в единой платформе, позволяя командам принимать data-driven решения на основе полной картины происходящего в системе.

Заключение

ELK-стек представляет собой гораздо больше, чем просто набор инструментов для работы с логами — это фундамент для построения культуры наблюдаемости (observability) в современных IT-системах. В мире, где downtime измеряется в потерянной выручке, а пользовательский опыт определяет конкурентоспособность, контроль и видимость происходящего в инфраструктуре становятся критически важными. Подведем итоги: ELK-стек объединяет Elasticsearch, Logstash и Kibana. Вместе они формируют единую систему централизованного логирования.

- Elasticsearch обеспечивает быстрый поиск и анализ. Его распределённая архитектура позволяет масштабировать обработку данных.

- Logstash отвечает за сбор и трансформацию логов. Он поддерживает множество плагинов и гибкую настройку фильтров.

- Kibana визуализирует данные. Графики и дашборды помогают находить закономерности и отслеживать метрики в реальном времени.

- Filebeat облегчает доставку логов. Этот агент минимизирует нагрузку на серверы и гарантирует надёжность передачи.

- ELK-стек применим в DevOps, безопасности и бизнес-аналитике. Он помогает решать задачи мониторинга, отладки и анализа поведения пользователей.

- У стека есть и ограничения. Высокие требования к ресурсам и сложность настройки требуют опыта и планирования.

- Несмотря на недостатки, ELK остаётся стандартом де-факто. Он сочетает масштабируемость, гибкость и доступность для команд любого размера.

Если вы только начинаете осваивать профессию DevOps-инженера или специалиста по аналитике данных, рекомендуем обратить внимание на подборку курсов по системной аналитике. В них есть и теоретическая, и практическая часть, что позволит быстрее понять ключевые принципы и закрепить их на реальных задачах.

Рекомендуем посмотреть курсы по системной аналитике

| Курс | Школа | Цена | Рассрочка | Длительность | Дата начала | Ссылка на курс |

|---|---|---|---|---|---|---|

|

Аналитик данных

|

Eduson Academy

110 отзывов

|

Цена

109 900 ₽

|

От

9 158 ₽/мес

Беспроцентная. На 1 год.

|

Длительность

6 месяцев

|

Старт

3 марта

|

Подробнее |

|

Системный аналитик PRO

|

Нетология

46 отзывов

|

Цена

79 800 ₽

140 000 ₽

с промокодом kursy-online

|

От

3 500 ₽/мес

Рассрочка на 2 года.

|

Длительность

10 месяцев

|

Старт

13 марта

|

Подробнее |

|

Системный аналитик с нуля

|

Stepik

33 отзыва

|

Цена

4 500 ₽

|

|

Длительность

1 неделя

|

Старт

в любое время

|

Подробнее |

|

Системный аналитик с нуля до PRO

|

Eduson Academy

110 отзывов

|

Цена

129 900 ₽

257 760 ₽

Ещё -10% по промокоду

|

От

10 825 ₽/мес

10 740 ₽/мес

|

Длительность

6 месяцев

|

Старт

в любое время

|

Подробнее |

Пользовательские сценарии: инструмент для UX-дизайнера

Хотите, чтобы пользователи легко взаимодействовали с вашим продуктом? Тогда вам не обойтись без продуманных пользовательских сценариев.

OpenCV в Python: зачем нужен и как использовать для работы с изображениями

OpenCV — не просто библиотека, а мощный инструмент для тех, кто хочет научить машину обрабатывать изображения. Где его применяют, как начать и на что обратить внимание? Объясняем на понятном языке.

Глубина цвета: что это, как работает и как выбрать подходящую битность

Глубина цвета — это не просто технический параметр, а основа качественного изображения. В статье простым языком объясняем, почему битность важна, что менять при обработке и как избежать типичных ошибок. Хотите разобраться, какой режим выбрать для своих задач? Давайте разбираться вместе.

Работа психологом онлайн — как найти клиентов и сделать практику прибыльной

Онлайн-формат работы дает гибкость, но требует новых подходов. Как организовать консультации и найти клиентов? Разбираем все нюансы.